NVIDIA представила линейку моделей OpenReasoning-Nemotron с параметрами от 1,5 до 32 миллиардов

Сегодня NVIDIA анонсировала OpenReasoning-Nemotron — набор из четырёх компактных моделей для логических рассуждений с параметрами 1,5 млрд, 7 млрд, 14 млрд и 32 млрд. Все они созданы на основе гигантской модели DeepSeek R1 0528 с 671 млрд параметров. Благодаря сжатию исходной «учительской» модели в четыре более лёгкие версии на базе Qwen‑2.5, NVIDIA делает передовые эксперименты с ИИ доступными даже для обычных игровых ПК, без необходимости аренды мощных GPU в облаке.

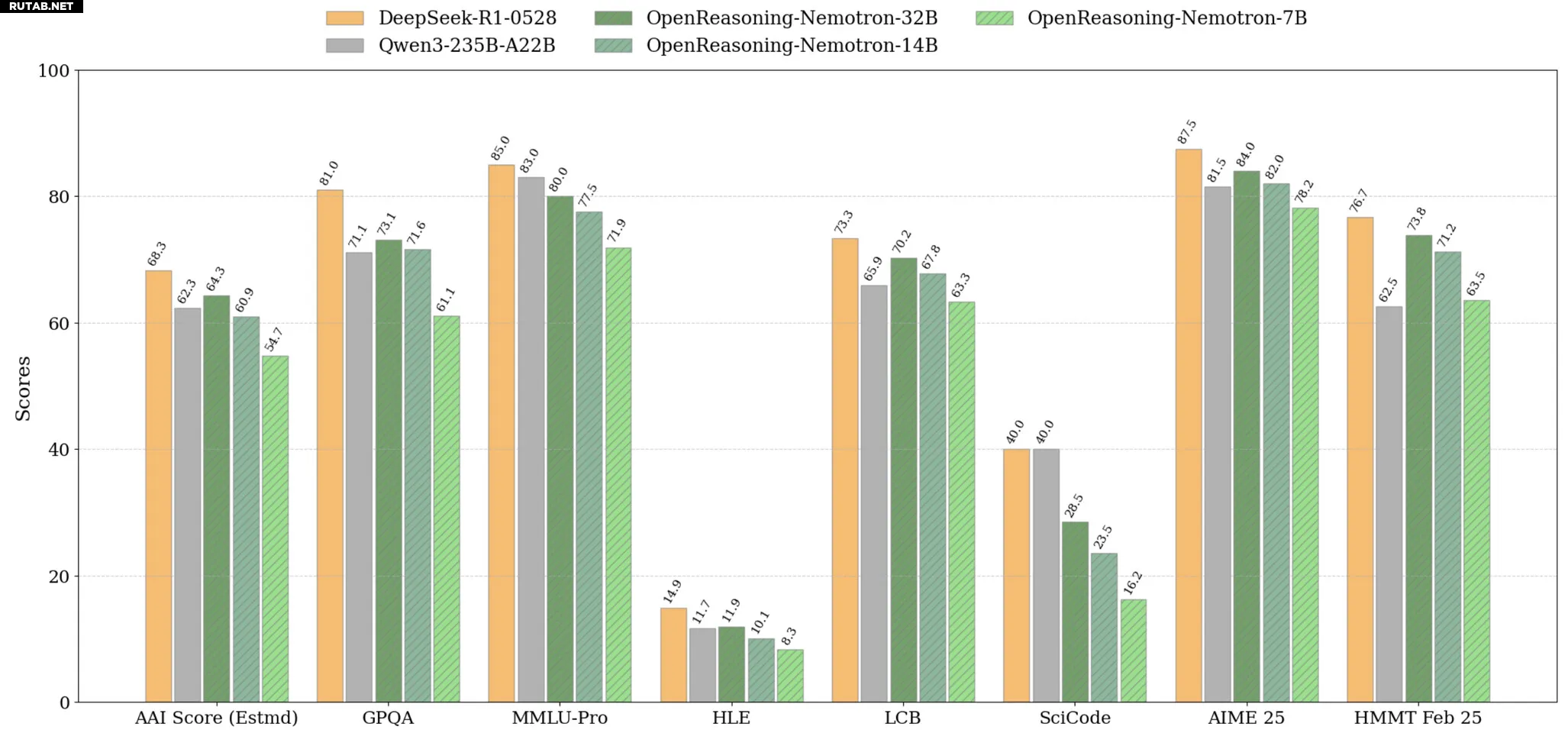

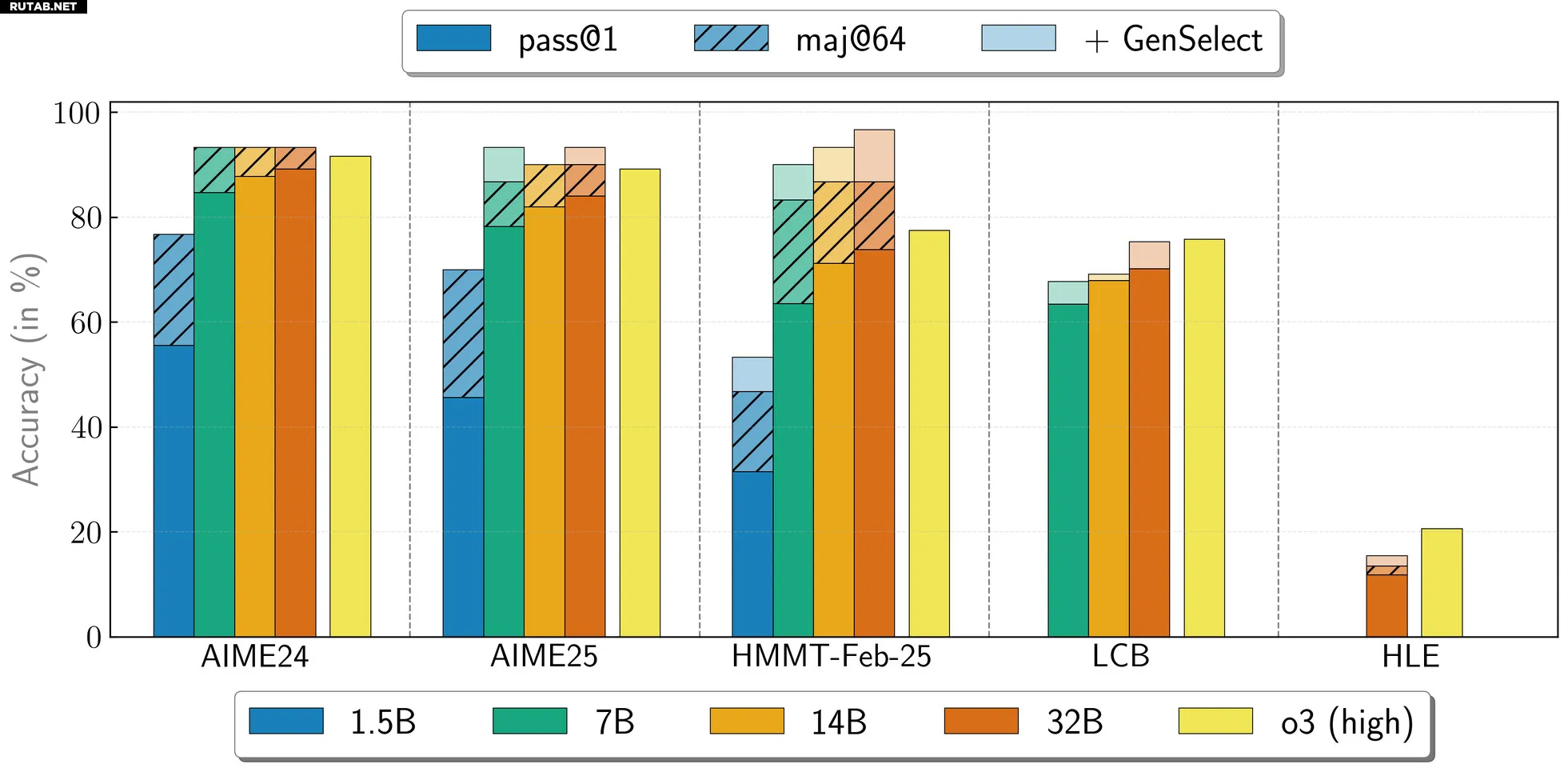

Ключевым фактором успеха стал не хитрый алгоритм, а огромный объём данных. Используя конвейер NeMo Skills, NVIDIA сгенерировала пять миллионов решений задач по математике, естественным наукам и программированию, а затем дообучила каждую модель методом контролируемого обучения. Уже сейчас 32-миллиардная модель демонстрирует результат 89,2 балла на тесте AIME24 и 73,8 на соревновании HMMT February. Даже самая компактная версия с 1,5 млрд параметров показывает достойные 55,5 и 31,5 балла соответственно.

NVIDIA позиционирует эти модели как мощный исследовательский инструмент. Все четыре версии будут доступны для загрузки на платформе Hugging Face, предоставляя надёжную основу для экспериментов с обучением с подкреплением или адаптацией под конкретные задачи. Благодаря функции GenSelect (которая делает несколько проходов для каждого вопроса) можно генерировать несколько параллельных ответов и выбирать лучший, что позволяет 32-миллиардной модели достигать результатов, сопоставимых или даже превосходящих OpenAI o3‑high на некоторых математических и программистских тестах.

Поскольку NVIDIA обучала эти модели исключительно методом контролируемого обучения, без использования обучения с подкреплением, сообщество получает чистые, современные отправные точки для будущих экспериментов с RL. Для геймеров и энтузиастов это означает возможность работать с почти топовыми моделями локально — при наличии достаточно мощной игровой видеокарты.

Источник: NVIDIA

0 комментариев