Стартап при поддержке Nvidia представил систему Ethernet-памяти для ускорения работы ИИ

Объем оперативной памяти часто становится узким местом для многих приложений искусственного интеллекта, но добавление памяти в хост-системы иногда невозможно или слишком сложно. Стартап Enfabrica, поддержанный Nvidia, разработал систему Emfasys, которая позволяет добавлять терабайты DDR5-памяти к любому серверу через Ethernet-подключение. Эта система памяти, работающая через Ethernet, предназначена для масштабных задач вывода (inference) и уже тестируется у избранных клиентов.

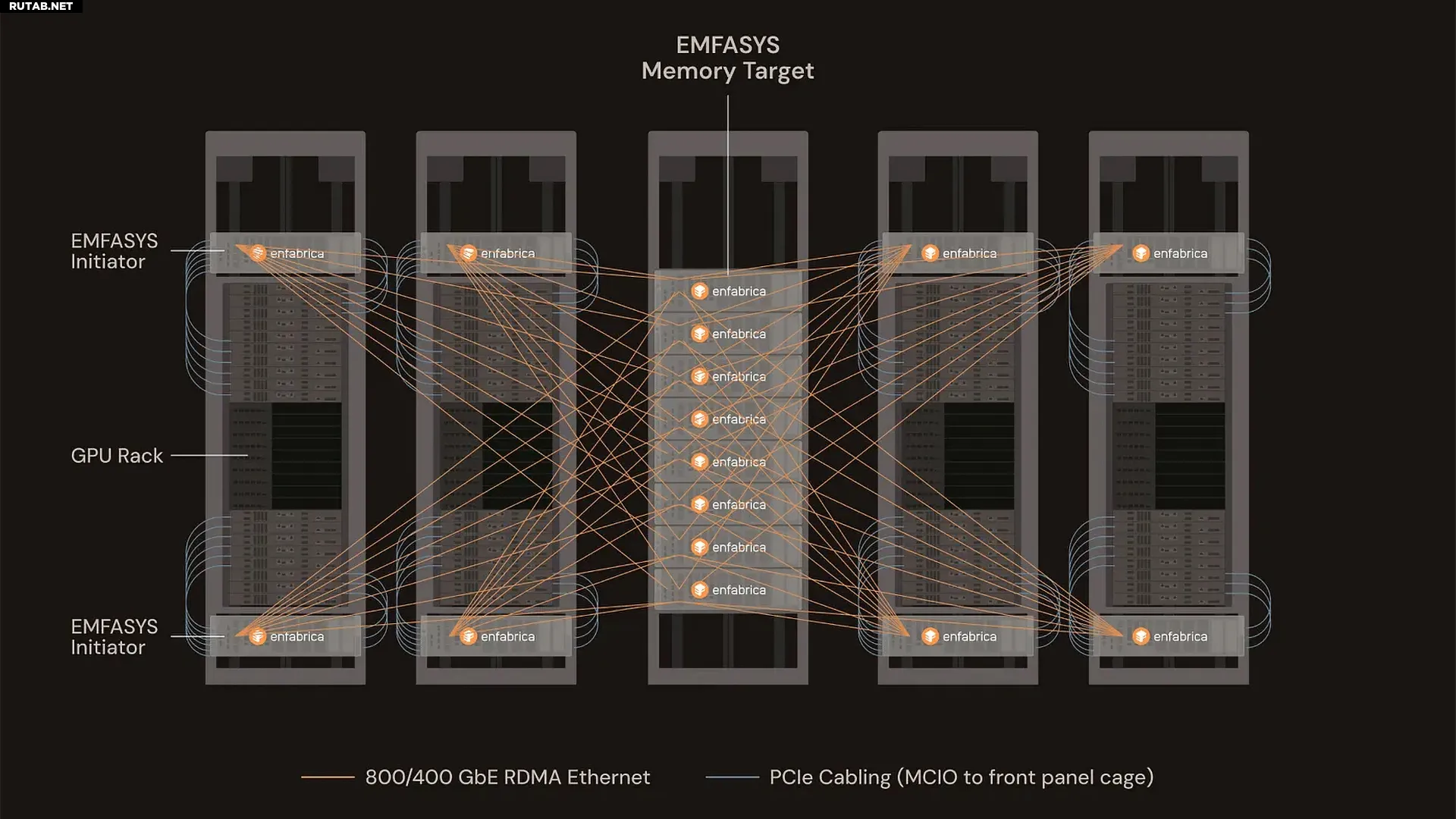

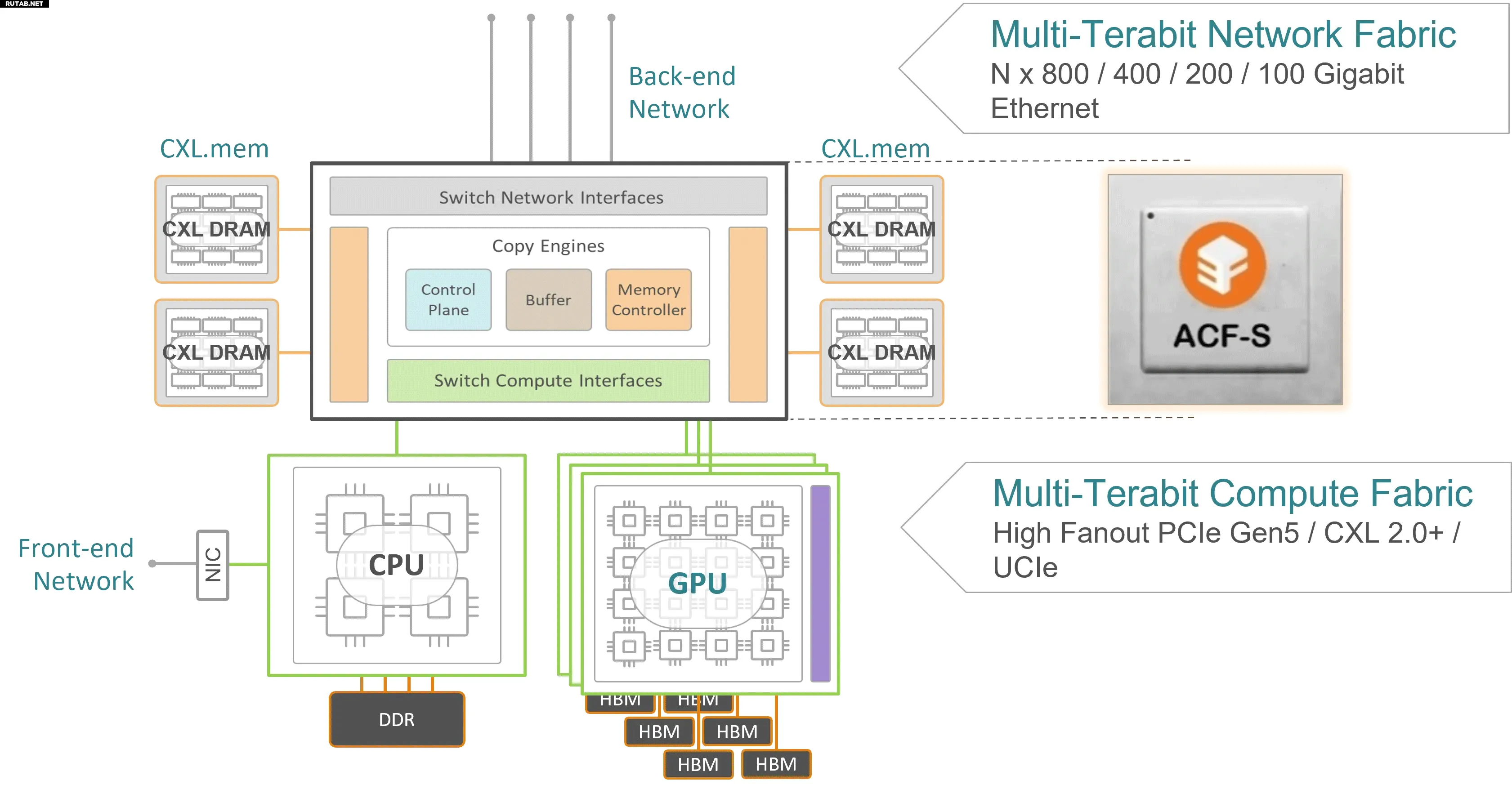

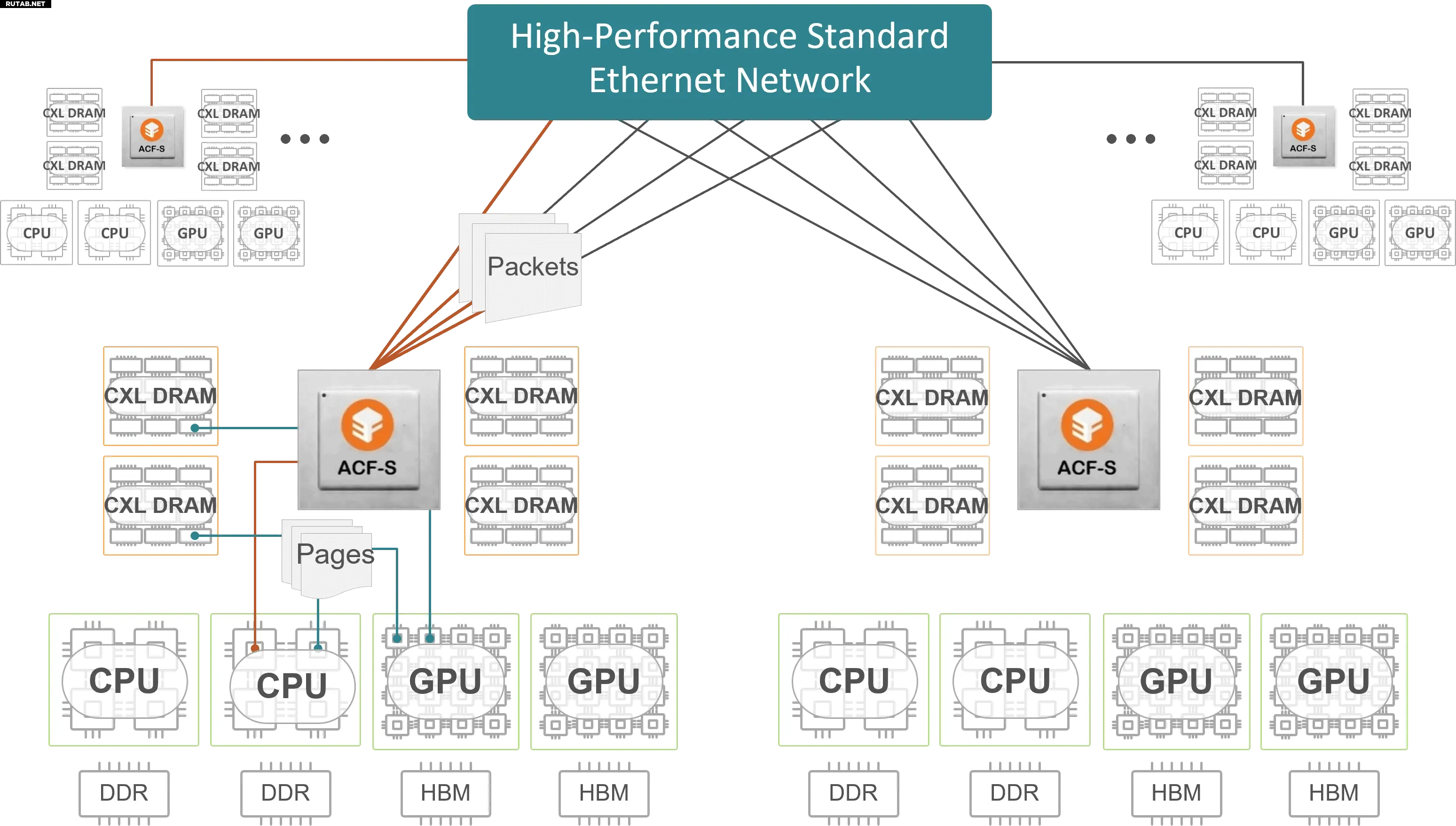

Система Emfasys от Enfabrica представляет собой совместимую со стандартными стойками платформу на базе чипа ACF-S SuperNIC с пропускной способностью 3,2 Тбит/с (400 ГБ/с). Она поддерживает до 18 ТБ DDR5-памяти с технологией CXL. Пул памяти доступен для серверов с 4 и 8 GPU через стандартные порты Ethernet 400G или 800G с использованием технологии Remote Direct Memory Access (RDMA). Это делает интеграцию Emfasys практически в любой ИИ-сервер максимально простой.

Изображение: Enfabrica

Передача данных между GPU-серверами и пулом памяти Emfasys осуществляется через RDMA, что обеспечивает доступ к памяти с низкой задержкой (измеряемой в микросекундах) без участия CPU, используя протокол CXL.mem. Для работы с пулом памяти серверы требуют специального ПО для управления памятью, которое маскирует задержки передачи и другие нюансы. Это ПО предоставляется Enfabrica и работает на стандартном оборудовании и ОС, используя распространенные интерфейсы RDMA, что упрощает развертывание системы без серьезных изменений в архитектуре.

Изображение: Enfabrica

Emfasys разработан для решения растущих требований к памяти в современных ИИ-сценариях, таких как обработка длинных запросов, большие контекстные окна или работа с множеством агентов. Эти задачи создают значительную нагрузку на высокоскоростную память HBM в GPU, которая ограничена по объему и дорога. Внешний пул памяти позволяет операторам дата-центров гибко расширять ресурсы отдельных серверов, что особенно полезно в подобных сценариях.

Использование Emfasys повышает эффективность ИИ-серверов, так как вычислительные ресурсы используются рациональнее, дорогая GPU-память не расходуется впустую, а общие затраты на инфраструктуру снижаются. По данным Enfabrica, такая система может сократить стоимость генерации одного токена в ИИ на 50% в задачах с высокой нагрузкой и длинным контекстом. Кроме того, распределение задач генерации токенов между серверами становится более равномерным, что устраняет узкие места.

«У ИИ-инференса есть проблема масштабирования пропускной способности памяти и накопления запасов памяти, — сказал Рочан Санкар, CEO Enfabrica. — По мере того как инференс становится более агентным, а не разговорным, более запоминающим, чем забывающим, текущие методы масштабирования доступа к памяти перестают работать. Мы создали Emfasys, чтобы решить эти проблемы новым способом. Клиенты заинтересованы в сотрудничестве с нами для создания более масштабируемой архитектуры перемещения памяти для их GenAI-нагрузок».

Система Emfasys и чип ACF SuperNIC с пропускной способностью 3,2 Тбит/с сейчас проходят тестирование у избранных клиентов. Точные сроки коммерческого релиза пока неизвестны.

Enfabrica активно участвует в работе Ultra Ethernet Consortium (UEC) и Ultra Accelerator Link (UALink) Consortium, что дает представление о стратегическом направлении компании.

Источник: Tomshardware.com

0 комментариев