NVIDIA TensorRT удваивает производительность AI-инференса на видеокартах RTX

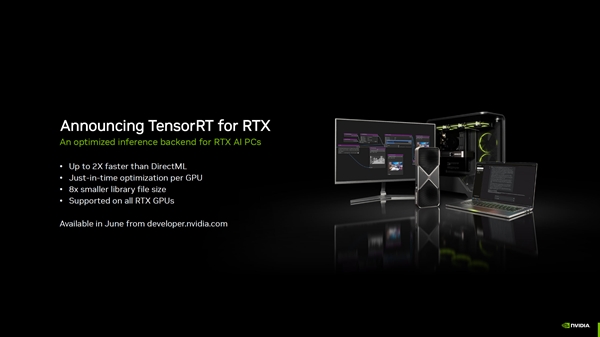

NVIDIA объявила о расширении поддержки фреймворка TensorRT для видеокарт GeForce RTX, что обеспечивает двукратный прирост производительности по сравнению с DirectML.

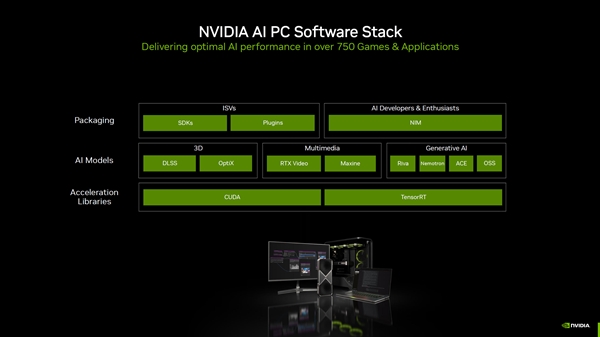

TensorRT — это оптимизатор AI-инференса, который теперь доступен для всех видеокарт RTX. Решение автоматически выбирает оптимальное аппаратное обеспечение для выполнения AI-задач и загружает необходимые компоненты, упрощая процесс разработки.

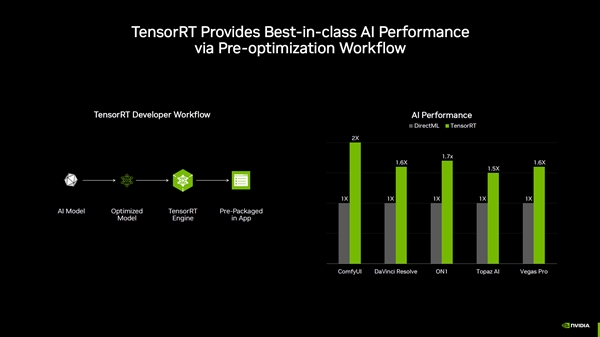

Согласно тестам NVIDIA, TensorRT демонстрирует следующие преимущества:

- До 2× ускорение в ComfyUI

- До 60% прирост производительности в DaVinci Resolve и Vegas Pro

Дополнительные преимущества TensorRT for RTX включают:

- В 8 раз меньший размер библиотек

- Мгновенную оптимизацию под конкретные GPU

Официальный релиз TensorRT for RTX запланирован на июнь 2025 года. NVIDIA также расширяет поддержку AI SDK — в мае добавлено 5 новых интеграций, включая Topaz Video AI и Autodesk VRED.

ИИ: Это значительное обновление делает AI-инференс более доступным для обычных пользователей, а не только для облачных решений. Особенно впечатляет двукратный прирост в ComfyUI — популярном инструменте для работы с Stable Diffusion.

0 комментариев