Новая технология 3D-памяти от d-Matrix может превзойти HBM в задачах ИИ-инференса

Стартап d-Matrix заявляет, что его 3D-память будет до 10 раз быстрее и эффективнее, чем HBM (High Bandwidth Memory). Технология 3D Digital In-Memory Compute (3DIMC) компании представляет собой решение для типа памяти, специально созданного для задач ИИ-инференса.

Высокопроизводительная память HBM стала неотъемлемой частью искусственного интеллекта и высокопроизводительных вычислений. Однако, хотя её популярность продолжает расти, HBM может быть не лучшим решением для всех вычислительных задач: если она критична для обучения ИИ, то в инференсе её могут превзойти другие технологии.

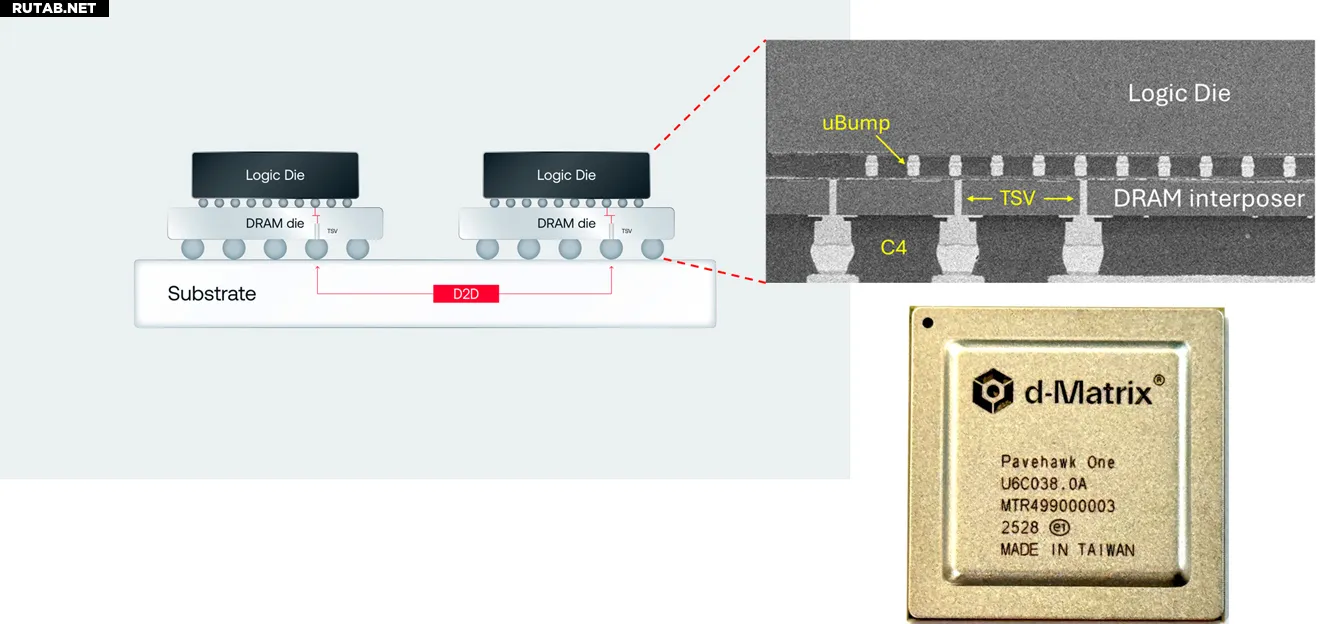

d-Matrix уже запустила в лаборатории свой чип Pavehawk 3DIMC. Аппаратное обеспечение Digital In-Memory Compute в настоящее время выглядит как кристаллы памяти LPDDR5 с чиплетами DIMC, расположенными сверху и соединёнными через интерпозер. Такая конфигурация позволяет аппаратуре DIMC выполнять вычисления непосредственно в памяти. Логические кристаллы DIMC оптимизированы для матрично-векторного умножения — распространённой операции в трансформерных моделях ИИ.

«Мы считаем, что будущее ИИ-инференса зависит от переосмысления не только вычислений, но и самой памяти, — заявил основатель и генеральный директор d-Matrix Сид Шетх. — Инференс ИИ ограничен памятью, а не только FLOPs. Модели быстро растут, а традиционные системы памяти HBM становятся очень дорогими, энергоёмкими и ограниченными по пропускной способности. 3DIMC меняет правила игры. Стекируя память в трёх измерениях и теснее интегрируя её с вычислениями, мы значительно снижаем задержки, улучшаем пропускную способность и открываем новые возможности для повышения эффективности».

Сейчас Pavehawk работает в лабораториях d-Matrix, и компания уже смотрит в будущее — на следующее поколение Raptor. В сообщениях компании утверждается, что это поколение, также построенное на модели чиплетов, превзойдёт HBM в 10 раз в задачах инференса при потреблении на 90% меньше энергии.

Проект DIMC от d-Matrix следует тенденции, которую мы наблюдаем у недавних стартапов и технических теоретиков: специфические вычислительные задачи, такие как обучение ИИ и инференс, должны иметь аппаратное обеспечение, специально разработанное для эффективного выполнения именно этих задач. d-Matrix утверждает, что ИИ-инференс, который сейчас составляет 50% рабочих нагрузок ИИ у некоторых гиперскейлеров, достаточно отличается от обучения, чтобы заслуживать отдельный тип памяти.

Замена HBM также привлекательна с финансовой точки зрения. HBM производят лишь несколько глобальных компаний, включая SK hynix, Samsung и Micron, и её цены далеко не низкие. SK hynix недавно оценила, что рынок HBM будет расти на 30% ежегодно до 2030 года, а цены будут расти вслед за спросом. Альтернатива этому гиганту может быть привлекательной для экономных покупателей ИИ-решений, хотя память, сделанная исключительно для определённых рабочих процессов и вычислений, может показаться слишком узконаправленной для потенциальных клиентов, опасающихся пузырей.

0 комментариев