OpenAI переходит с NVIDIA на Google Cloud для снижения затрат

OpenAI начало сотрудничество с Google Cloud, используя процессоры TPU для работы ChatGPT и других своих продуктов. Это стратегическое решение направлено на сокращение огромных вычислительных затрат и снижение зависимости от Microsoft Azure.

Финансовое давление стало основной причиной этого шага — расходы на вычисления составляют 55-60% от 9 миллиардов долларов (≈746 млрд руб.) годовых операционных затрат компании. В 2025 году эта доля может превысить 80%.

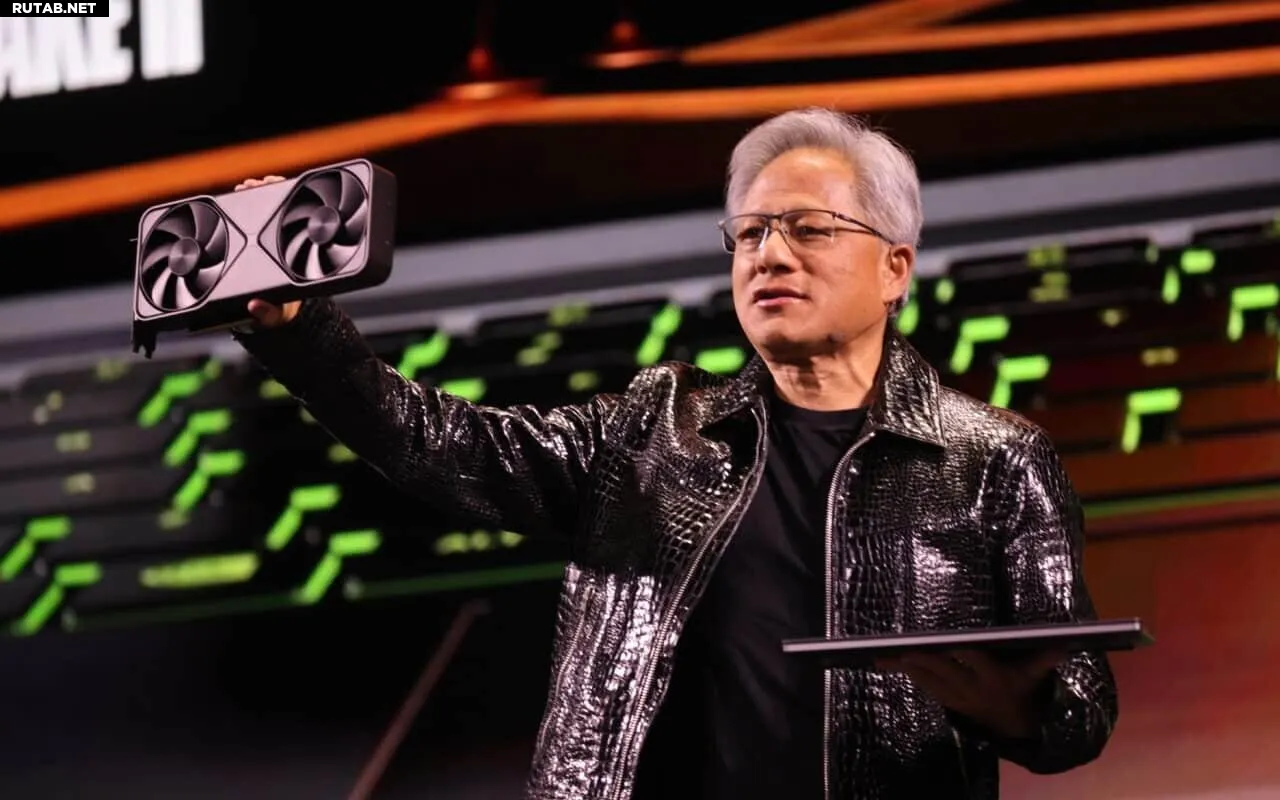

Google предлагает услуги AI Compute примерно на 20% дешевле, чем стоимость чипов NVIDIA. Разница заметна в ценах на модели: Gemini 2.5 Pro стоит 10 долларов (≈830 руб.) за миллион токенов, тогда как аналогичная модель OpenAI — 40 долларов (≈3310 руб.).

Этот переход означает конец эксклюзивного партнерства с Microsoft Azure, действовавшего с 2019 года. Ограничение истекло в январе 2025-го, позволив OpenAI диверсифицировать инфраструктуру.

Парадоксально, но Google поддерживает своего главного конкурента в сфере ИИ, одновременно ограничивая доступ к самым передовым чипам TPU, чтобы сохранить конкурентное преимущество.

OpenAI также расширяет сотрудничество с Oracle и CoreWeave, уменьшая зависимость от единственного поставщика и готовясь к растущим энергетическим потребностям сектора ИИ.

0 комментариев