Энергопотребление NVIDIA Blackwell повышает требования к охлаждению

Читайте также:Nvidia и партнеры могут взимать до 3 миллионов долларов за серверный шкаф BlackwellNvidia готовит новый графический процессор TitanNvidia готовит для Китая версию графического процессора B200 Blackwell AINVIDIA опередила Microsoft и стала самой дорогой компанией в миреСтали известны возможные характеристики линейки графических процессоров NVIDIA GeForce «Blackwell»

Системы воздушного и жидкостного охлаждения для удовлетворения более высоких требований к охлаждению

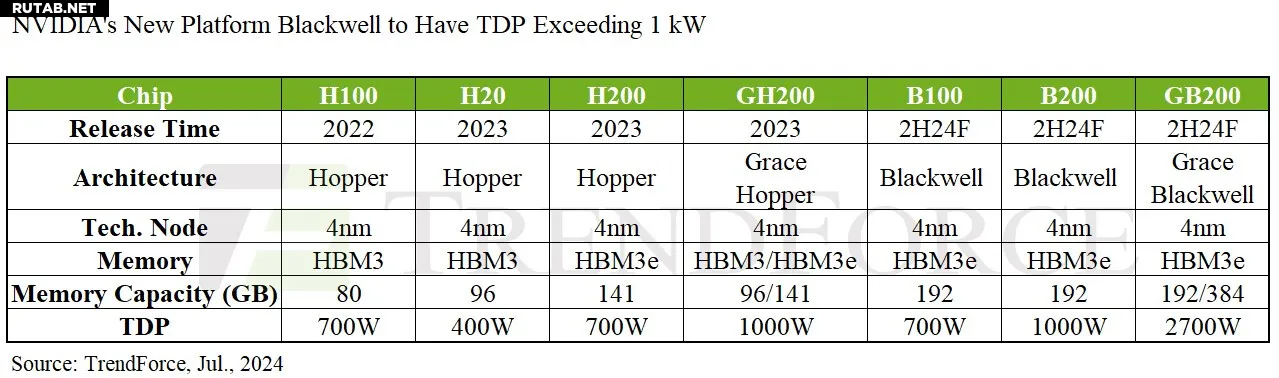

TrendForce сообщает, что платформа NVIDIA Blackwell будет официально запущена в 2025 году, заменив текущую платформу Hopper и став доминирующим решением для высокопроизводительных графических процессоров NVIDIA, на долю которых приходится почти 83% всех высокопроизводительных продуктов. Модели высокопроизводительных серверов искусственного интеллекта, такие как B200 и GB200, разработаны для максимальной эффективности: отдельные графические процессоры потребляют более 1000 Вт. Модели HGX будут содержать по 8 графических процессоров каждая, а модели NVL будут поддерживать 36 или 72 графических процессора на стойку, что значительно ускорит рост цепочка поставок жидкостного охлаждения для серверов искусственного интеллекта.

TrendForce подчеркивает рост TDP серверных чипов: TDP чипа B200 достигает 1000 Вт, что делает традиционные решения воздушного охлаждения неадекватными. По прогнозам, TDP комплектных стоечных систем GB200 NVL36 и NVL72 достигнет 70 кВт и почти 140 кВт соответственно, что требует применения передовых решений жидкостного охлаждения для эффективного управления теплом.

TrendForce отмечает, что архитектура GB200 NVL36 первоначально будет использовать комбинацию решений воздушного и жидкостного охлаждения, тогда как NVL72, из-за более высоких требований к охлаждению, будет в основном использовать жидкостное охлаждение.

TrendForce выделяет пять основных компонентов в текущей цепочке поставок жидкостного охлаждения для стоечных систем GB200: охлаждающие пластины, блоки распределения охлаждающей жидкости (CDU), коллекторы, быстроразъемные соединения (QD) и теплообменники с задней дверцей (RDHx).

CDU — это важнейшая система, отвечающая за регулирование потока охлаждающей жидкости для поддержания температуры стойки в пределах заданного диапазона TDP, предотвращая повреждение компонентов. Vertiv в настоящее время является основным поставщиком CDU для решений NVIDIA AI, а Chicony, Auras, Delta и CoolIT проходят постоянное тестирование.

Ожидается, что поставки GB200 достигнут 60 000 единиц в 2025 году, что сделает Blackwell основной платформой и составит более 80% высокопроизводительных графических процессоров NVIDIA.

В 2025 году NVIDIA будет предлагать поставщикам услуг связи и корпоративным клиентам разнообразные конфигурации серверов искусственного интеллекта, включая HGX, GB200 Rack и MGX, с ожидаемым соотношением поставок 5:4:1. Платформа HGX плавно перейдет из существующей платформы Hopper, что позволит операторам связи и крупным корпоративным клиентам быстро внедрить ее. Стоечный AI-сервер GB200 будет в первую очередь ориентирован на рынок гипермасштабируемых CSP. TrendForce прогнозирует, что NVIDIA представит конфигурацию NVL36 в конце 2024 года, чтобы быстро выйти на рынок, а выпуск более сложной конфигурации NVL72 ожидается в 2025 году.

TrendForce прогнозирует, что в 2025 году поставки GB200 NVL36 достигнут 60 000 стоек, а использование графических процессоров Blackwell составит от 2,1 до 2,2 миллиона единиц.

Однако существует несколько факторов, влияющих на принятие стойки GB200 конечными потребителями. TrendForce отмечает, что энергопотребление NVL72, составляющее около 140 кВт на стойку, требует сложных решений жидкостного охлаждения, что усложняет задачу. Кроме того, конструкции стоек с жидкостным охлаждением больше подходят для новых центров обработки данных CSP, но требуют сложных процессов планирования. Поставщики услуг связи могут также избегать привязки к спецификациям одного поставщика и выбирать модели HGX или MGX с архитектурой процессора x86 или расширять свою самостоятельно разработанную инфраструктуру серверов ASIC AI для снижения затрат или конкретных приложений AI.

Источник: TrendForce

0 комментариев