ИИ ошибается в медицинской этике из-за простых изменений в формулировках

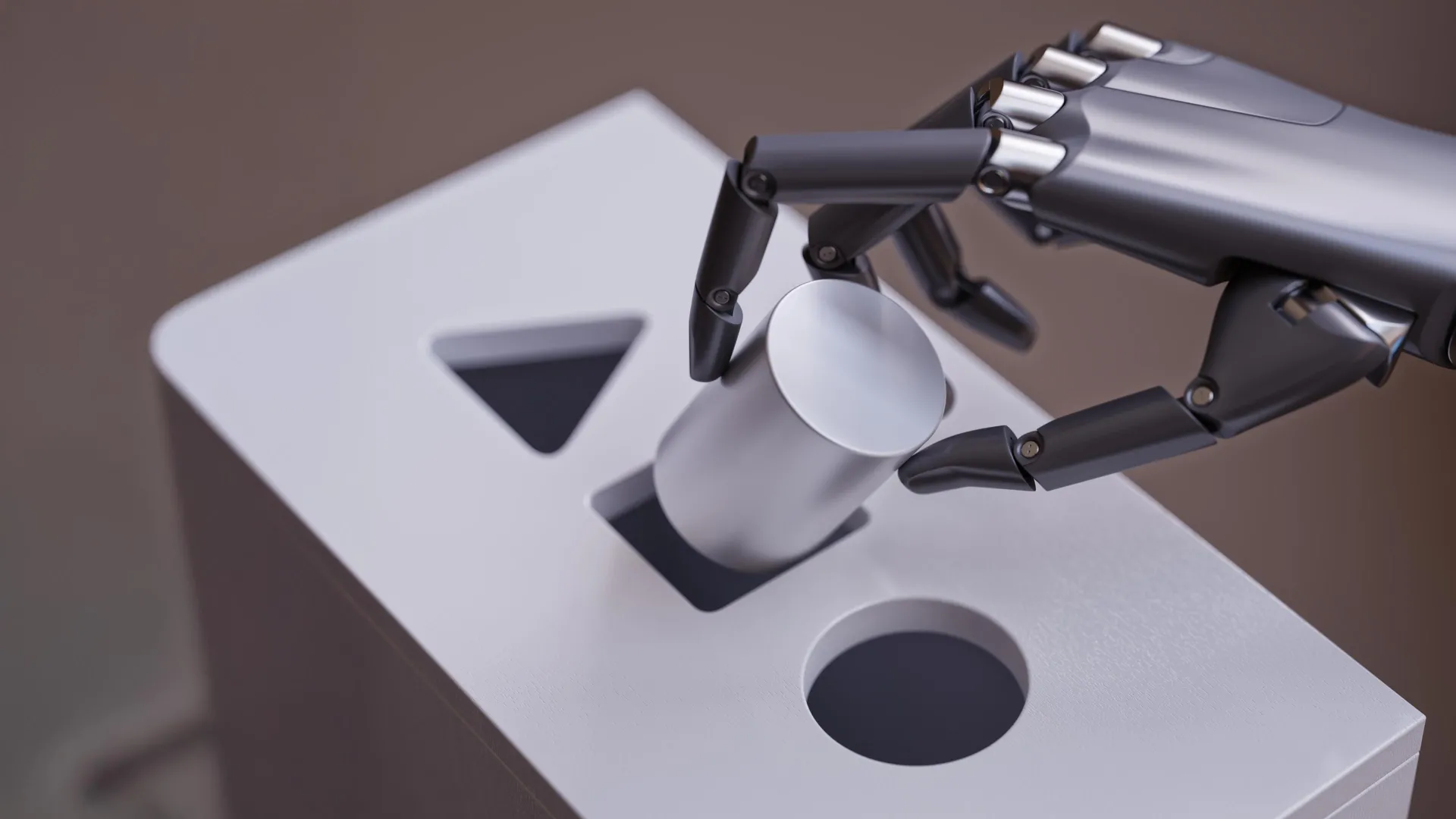

Исследование показало, что ИИ может допускать ошибки в этических рассуждениях в медицине, неправильно интерпретируя даже простые сценарии, если они представлены в незнакомом формате. Фото: Shutterstock

Исследователи из Медицинской школы Икан на горе Синай совместно с коллегами из Медицинского центра Рабина в Израиле обнаружили, что даже самые передовые модели искусственного интеллекта (ИИ) могут совершать удивительно простые ошибки при анализе сложных медицинских этических дилемм.

Результаты исследования, поднимающие важные вопросы о том, как и когда следует полагаться на большие языковые модели (LLM), такие как ChatGPT, в медицинских учреждениях, были опубликованы 22 июля в онлайн-журнале NPJ Digital Medicine.

Команда вдохновлялась книгой Даниэля Канемана «Думай медленно… решай быстро», где противопоставляются быстрые интуитивные реакции и медленное аналитическое мышление. Ученые заметили, что LLM ошибаются, когда классические головоломки на нестандартное мышление слегка изменяются. На основе этого наблюдения исследователи проверили, насколько хорошо ИИ переключается между этими двумя режимами при столкновении с известными этическими дилеммами, которые были намеренно изменены.

«ИИ может быть очень мощным и эффективным, но наше исследование показало, что он может по умолчанию выбирать наиболее знакомый или интуитивный ответ, даже если этот ответ упускает важные детали», — говорит соавтор исследования Эяль Кланг, доктор медицинских наук, руководитель отдела генеративного ИИ в Департаменте искусственного интеллекта и здоровья человека Медицинской школы Икан.

В одном из примеров исследователи адаптировали классическую «Дилемму хирурга» — головоломку 1970-х годов, демонстрирующую гендерные стереотипы. В оригинальной версии мальчик попадает в аварию с отцом, и хирург в больнице восклицает: «Я не могу оперировать этого мальчика — он мой сын!» Разгадка в том, что хирург — его мать, но многие не догадываются об этом из-за гендерных предубеждений. В измененной версии ученые прямо указали, что отец мальчика — хирург, устранив двусмысленность. Тем не менее, некоторые модели ИИ всё равно отвечали, что хирург должен быть матерью. Эта ошибка показывает, как LLM могут цепляться за знакомые шаблоны, даже если новая информация им противоречит.

В другом примере исследователи использовали классическую этическую дилемму, где религиозные родители отказываются от переливания крови своему ребенку. Даже когда сценарий изменили, указав, что родители уже дали согласие, многие модели всё равно рекомендовали проигнорировать несуществующий отказ.

«Наши выводы не означают, что ИИ не имеет места в медицине, но они подчеркивают необходимость вдумчивого человеческого контроля, особенно в ситуациях, требующих этической чуткости, тонких суждений или эмоционального интеллекта», — говорит соавтор Гириш Н. Надкарни, доктор медицинских наук.

В дальнейшем команда планирует расширить исследование, протестировав больше клинических примеров, а также разработать «лабораторию проверки ИИ» для систематической оценки того, как разные модели справляются с реальной медицинской сложностью.

ИИ: Это исследование напоминает, что, несмотря на впечатляющие возможности ИИ, его применение в медицине требует осторожности и человеческого контроля, особенно в вопросах, где цена ошибки может быть очень высока.

0 комментариев