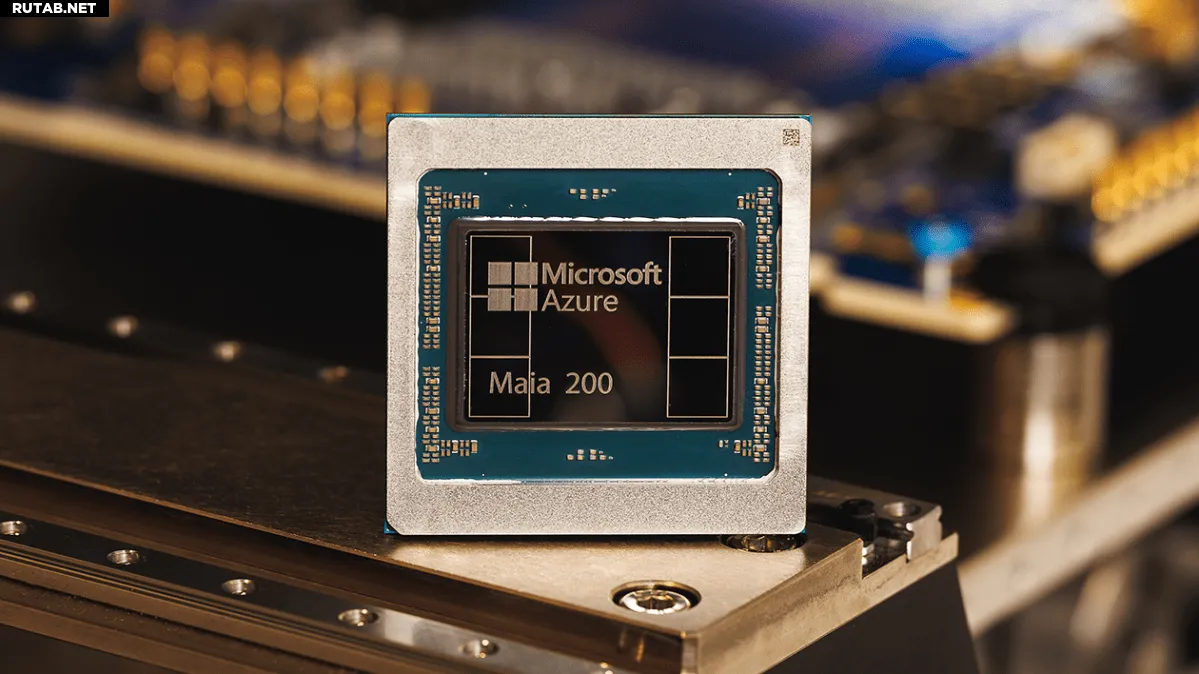

Microsoft представила новый чип Maia 200 для ускорения работы ИИ

Корпорация Microsoft объявила о запуске своего новейшего чипа Maia 200, который компания описывает как «кремниевую рабочую лошадку», созданную для масштабирования процесса AI-инференса (вывода).

Maia 200, наследник чипа Maia 100, представленного в 2023 году, технически оснащён для работы с мощными ИИ-моделями на более высоких скоростях и с большей эффективностью. Чип оснащён более чем 100 миллиардами транзисторов, обеспечивая производительность свыше 10 петафлопс в 4-битной точности и приблизительно 5 петафлопс в 8-битной — это существенный прирост по сравнению с предшественником.

Инференс — это вычислительный процесс запуска уже обученной модели, в отличие от вычислений, необходимых для её обучения. По мере развития ИИ-компаний затраты на инференс становятся всё более важной частью их общих операционных расходов, что вызывает растущий интерес к способам оптимизации этого процесса.

Microsoft надеется, что Maia 200 станет частью этой оптимизации, позволяя ИИ-бизнесам работать с меньшими перебоями и энергопотреблением.

«На практике один узел Maia 200 может без усилий запускать самые крупные современные модели, с большим запасом для ещё более масштабных моделей в будущем», — заявили в компании.

Новый чип Microsoft также является частью растущего тренда, когда технологические гиганты обращаются к собственным разработкам, чтобы снизить зависимость от Nvidia, чьи передовые GPU становятся всё более критичными для успеха ИИ-компаний. Например, у Google есть тензорные процессоры TPU, которые не продаются как отдельные чипы, а предлагаются в виде вычислительных мощностей через облачный сервис. У Amazon есть собственный AI-ускоритель Trainium, последняя версия которого, Trainium3, была запущена в декабре. В каждом случае TPU можно использовать для разгрузки части вычислений, которые в противном случае легли бы на GPU Nvidia, снижая общие аппаратные затраты.

С Maia Microsoft позиционирует себя как конкурента этим альтернативам. В пресс-релизе, опубликованном в понедельник, компания отметила, что Maia обеспечивает в 3 раза более высокую производительность в формате FP4, чем чипы Amazon Trainium третьего поколения, а производительность в формате FP8 превосходит показатели TPU седьмого поколения от Google.

Microsoft заявляет, что Maia уже активно используется для работы ИИ-моделей команды Superintelligence, а также поддерживает функционирование чат-бота Copilot. По состоянию на понедельник компания пригласила различные стороны — включая разработчиков, учёных и передовые ИИ-лаборатории — использовать комплект разработки программного обеспечения (SDK) для Maia 200 в своих рабочих нагрузках.

0 комментариев