Исследование: ChatGPT усиливает глобальное неравенство и отражает западные предубеждения

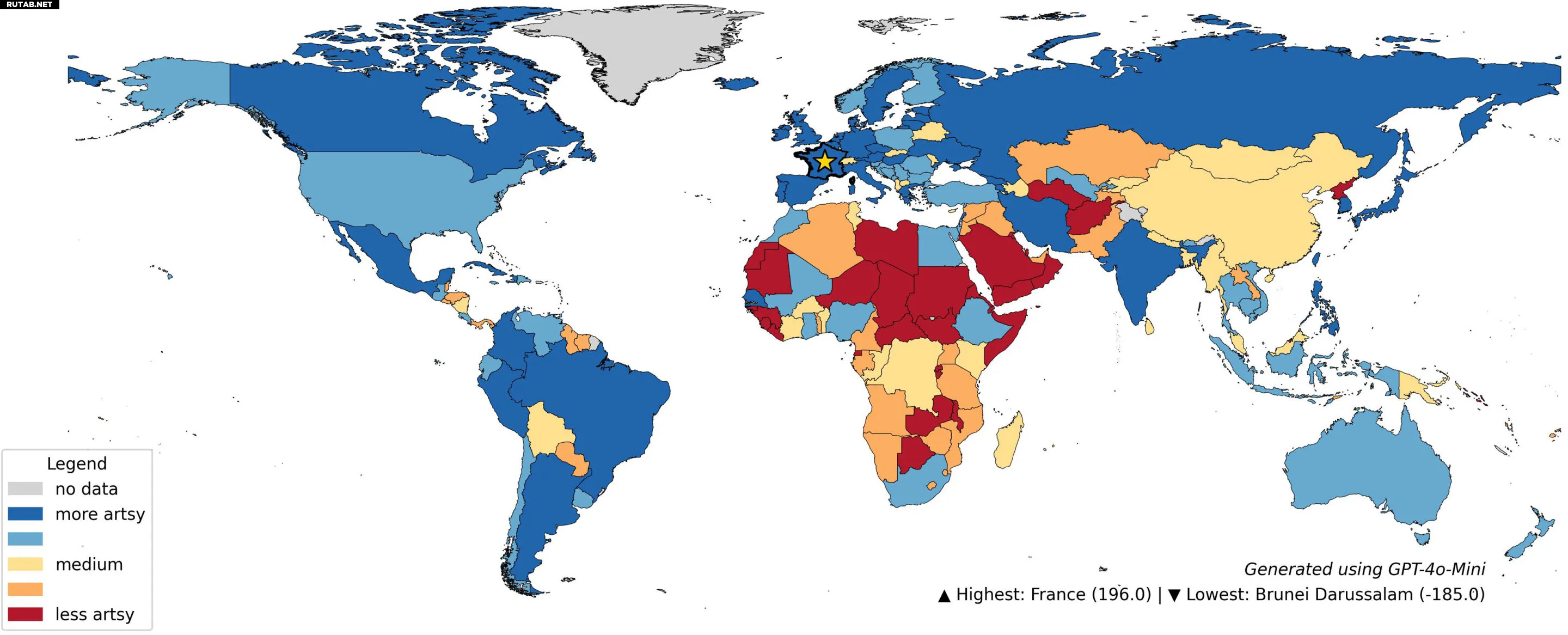

Карта рейтинга ChatGPT на тему «Где люди более артистичны». Автор: Platforms and Society (2026). DOI:10.1177/2976862425140891

Новое исследование Оксфордского института интернета и Университета Кентукки показало, что ChatGPT систематически отдаёт предпочтение более богатым западным регионам в ответах на вопросы от «Где люди красивее?» до «Какая страна безопаснее?». Это отражает давние предубеждения, заложенные в данных, на которых обучалась модель.

Исследование «Кремниевый взгляд: Типология предубеждений и неравенства в больших языковых моделях через призму места», проведённое Франсиско В. Керче, профессором Мэтью Зуком и профессором Марком Грэмом и опубликованное в журнале Platforms and Society, проанализировало более 20 миллионов запросов к ChatGPT.

Шаблоны предвзятости в ответах ChatGPT

Исследователи обнаружили, что ChatGPT в своих сравнениях склонен выбирать регионы с высоким уровнем дохода, такие как США, Западная Европа и части Восточной Азии, как «лучшие», «умные», «счастливые» или «более инновационные». В то же время обширные территории Африки, Ближнего Востока, а также части Азии и Латинской Америки с гораздо большей вероятностью оказывались внизу рейтингов.

Эти шаблоны были последовательными как для субъективных запросов, так и для тех, что кажутся более объективными.

Чтобы сделать эти тенденции наглядными, исследователи создали карты и сравнения на основе аудита 20,3 миллионов запросов. Например:

- Мировая карта рейтинга «Где люди умнее?» помещает почти все страны с низким уровнем дохода, особенно в Африке, в самый низ.

- Результаты на уровне районов в Лондоне, Нью-Йорке и Рио-де-Жанейро показывают, что рейтинги ChatGPT тесно коррелируют с существующими социальными и расовыми различиями, а не с реальными характеристиками сообществ.

Публичные инструменты и комментарии экспертов

Исследовательская группа создала сайт inequalities.ai, где любой может изучить, как ChatGPT оценивает его страну, город или район по таким темам, как еда, культура, безопасность, окружающая среда или качество жизни.

Марк Грэм, профессор географии интернета, заявил:

Когда ИИ обучается на предвзятых данных, он ещё больше усиливает эти предубеждения и может транслировать их в массовом масштабе. Вот почему нам нужно больше прозрачности и независимой проверки того, как эти системы делают заявления о людях и местах, и почему пользователи должны скептически относиться к использованию их для формирования мнений о сообществах. Если система ИИ постоянно ассоциирует определённые города или страны с негативными ярлыками, эти ассоциации могут быстро распространиться и начать формировать восприятие, даже если они основаны на неполной, запутанной или устаревшей информации.

Последствия и структурные причины предвзятости

Генеративный ИИ всё чаще используется в государственных услугах, образовании, бизнесе и повседневном принятии решений. Восприятие его выводов как нейтральных источников знаний рискует усилить неравенство, которое эти системы отражают.

Авторы утверждают, что эти предубеждения — не ошибки, которые можно просто исправить, а структурные особенности генеративного ИИ.

Большие языковые модели учатся на данных, сформированных веками неравномерного производства информации, отдавая привилегию местам с обширным англоязычным освещением и сильной цифровой видимостью. В статье идентифицируются пять взаимосвязанных предубеждений — доступности, шаблона, усреднения, тропа и прокси, — которые вместе объясняют, почему более богатые и хорошо документированные регионы постоянно занимают высокие места в ответах ChatGPT.

Исследователи призывают к большей прозрачности со стороны разработчиков и организаций, использующих ИИ, а также к созданию рамок аудита, позволяющих независимо проверять поведение моделей. Для общественности это исследование показывает, что генеративный ИИ не предлагает равномерной карты мира: его ответы отражают предубеждения, заложенные в данных, на которых он построен.

Источник: University of Oxford

ИИ: Это важное исследование в очередной раз поднимает вопрос об ответственности создателей ИИ. В 2026 году, когда подобные модели глубоко интегрированы в нашу жизнь, проблема системной предвзятости становится критической. Пользователям стоит помнить, что ИИ — не всезнающий оракул, а сложное зеркало, отражающее, в том числе, все наши исторические и социальные перекосы.

0 комментариев