Стартап Inception привлек $50 млн на разработку диффузионных моделей для работы с кодом и текстом

В условиях активного финансирования стартапов в сфере искусственного интеллекта исследователям становится проще находить ресурсы для проверки своих идей. Особенно если идея достаточно новаторская, и её проще реализовать в рамках независимой компании, чем внутри одной из крупных лабораторий.

Именно такова история стартапа Inception, который разрабатывает ИИ-модели на основе диффузии. Компания только что привлекла 50 миллионов долларов США (около 4 млн руб.) в рамках начального раунда финансирования. Раунд возглавила Menlo Ventures, при участии Mayfield, Innovation Endeavors, фонда M12 от Microsoft, Snowflake Ventures, Databricks Investment и венчурного подразделения Nvidia NVentures. Дополнительные ангельские инвестиции предоставили Эндрю Ын и Андрей Карпати.

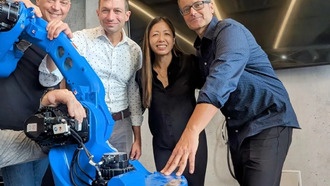

Руководит проектом профессор Стэнфорда Стефано Эрмон, чьи исследования сосредоточены на диффузионных моделях — они генерируют результат путем итеративного уточнения, а не слово за словом. Именно такие модели лежат в основе изображенческих ИИ-систем, таких как Stable Diffusion, Midjourney и Sora. Поработав над этими системами ещё до того, как ажиотаж вокруг ИИ сделал их популярными, Эрмон с помощью Inception применяет те же модели к более широкому кругу задач.

Параллельно с объявлением о финансировании компания выпустила новую версию своей модели Mercury, предназначенной для разработки программного обеспечения. Mercury уже интегрирована в ряд инструментов для разработчиков, включая ProxyAI, Buildglare и Kilo Code. Что важнее, по словам Эрмона, диффузионный подход поможет моделям Inception экономить два ключевых ресурса: задержку (время отклика) и вычислительные затраты.

«Эти диффузионные большие языковые модели гораздо быстрее и эффективнее того, что строят сегодня все остальные, — говорит Эрмон. — Это совершенно другой подход, в рамках которого ещё можно внести много инноваций».

Понимание технической разницы требует небольшого погружения в тему. Диффузионные модели структурно отличаются от авторегрессионных, которые доминируют в текстовых ИИ-сервисах. Авторегрессионные модели, такие как GPT-5 и Gemini, работают последовательно, предсказывая каждое следующее слово или его фрагмент на основе ранее обработанного материала. Диффузионные модели, обученные для генерации изображений, используют более целостный подход, постепенно меняя общую структуру ответа, пока он не будет соответствовать желаемому результату.

Сложившаяся практика рекомендует использовать авторегрессионные модели для текстовых приложений, и этот подход оказался чрезвычайно успешным для последних поколений ИИ-моделей. Однако всё больше исследований указывают на то, что диффузионные модели могут работать лучше, когда модель обрабатывает большие объемы текста или работает в условиях ограниченных данных. Как поясняет Эрмон, эти качества становятся реальным преимуществом при выполнении операций с большими кодобазами.

Диффузионные модели также обладают большей гибкостью в использовании аппаратного обеспечения, что является особенно важным преимуществом по мере роста инфраструктурных потребностей ИИ. В то время как авторегрессионные модели должны выполнять операции одна за другой, диффузионные модели могут обрабатывать множество операций одновременно, что позволяет значительно снизить задержку при выполнении сложных задач.

«Наши тесты показывают скорость более 1000 токенов в секунду, что намного выше, чем возможно с использованием существующих авторегрессионных технологий, — заявляет Эрмон. — Потому что наша система создана для параллельной работы. Она создана, чтобы быть очень и очень быстрой».

0 комментариев