Новая технология мембранного охлаждения устанавливает рекорд и может решить проблему перегрева серверов ИИ

Системы охлаждения для серверов искусственного интеллекта являются одними из самых энергоемких компонентов в дата-центрах. Инженеры из Калифорнийского университета в Сан-Диего разработали новую технологию охлаждения с использованием специально разработанной волоконной мембраны, которая может значительно сократить потребление энергии и воды для серверных стоек с GPU для ИИ.

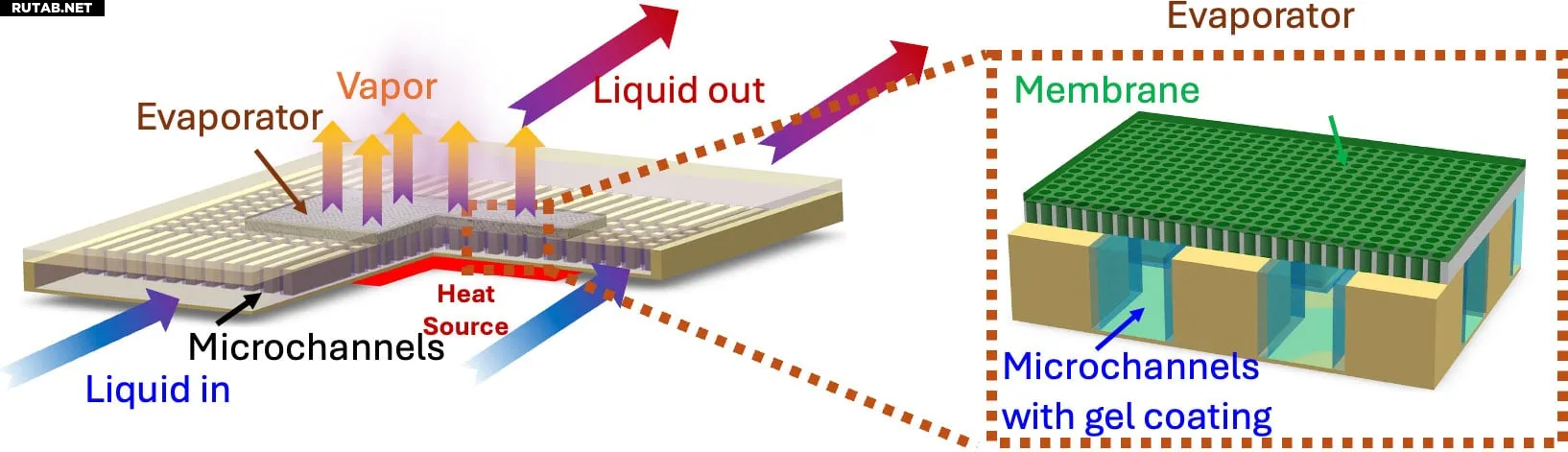

Мембранная система охлаждения использует принцип испарительного охлаждения для отвода тепла от компонентов. Мембрана состоит из взаимосвязанных микроскопических пор, которые за счет капиллярного эффекта распределяют хладагент по своей поверхности. Система имеет три слоя: нижний слой с микроканалами для прохождения жидкости, промежуточный слой с мембраной и верхний слой с испарителем. Когда хладагент проходит через микроканалы, он впитывается в мембрану, а тепло, генерируемое охлаждаемым компонентом, превращает жидкость в пар, который выходит через испарительный слой. Излишки хладагента, не превратившиеся в пар, остаются в микроканалах и, вероятно, рециркулируются.

Изображение: SciTechDaily

Сообщается, что данная конструкция решает проблемы предыдущих систем испарительного охлаждения с пористыми мембранами, где поры были либо слишком маленькими, что приводило к засорению, либо слишком большими, вызывая закипание хладагента. Новая система использует волоконные мембраны с оптимальным размером пор, что предотвращает как засорение, так и закипание.

Самое впечатляющее — эта разработка показала рекордные 800 Вт теплового потока на квадратный сантиметр и сохраняла стабильность в течение нескольких часов работы, что делает ее чрезвычайно перспективным решением для энергоемких применений в дата-центрах. Более того, система работает значительно ниже своих теоретических пределов, что говорит о возможности создания в будущем еще более мощных версий с улучшенными характеристиками охлаждения.

Такая технология охлаждения крайне необходима индустрии дата-центров на текущем этапе. Развитие искусственного интеллекта продолжает стремительно расти, а современные системы жидкостного охлаждения не справляются с нагрузками. Ожидается, что следующее поколение дата-центровых GPU Nvidia, таких как Feynman, которые появятся после архитектур Rubin/Rubin Ultra, будут потреблять колоссальные 4400 Вт мощности.

Источник: Tomshardware.com

0 комментариев