SK hynix представила полный портфель памяти для ИИ на саммите OCP

Южнокорейская компания SK hynix продемонстрировала полный портфель решений памяти для искусственного интеллекта и инфраструктуры центров обработки данных на глобальном саммите OCP 2025 в Сан-Хосе. Мероприятие проходило с 13 по 16 октября под темой «Лидируя в будущем ИИ» и собрало экспертов ведущих мировых компаний.

Под слоганом «ПАМЯТЬ, питающая ИИ и завтрашний день» компания представила ряд инновационных технологий, улучшающих производительность и эффективность ИИ-инфраструктуры. Центральным экспонатом стал революционный 12-слойный HBM4, разработка которого была завершена в сентябре 2025 года. Новая память обладает 2048 каналами ввода-вывода — вдвое больше, чем у предыдущего поколения, — что обеспечивает повышенную пропускную способность и более чем на 40% лучшую энергоэффективность.

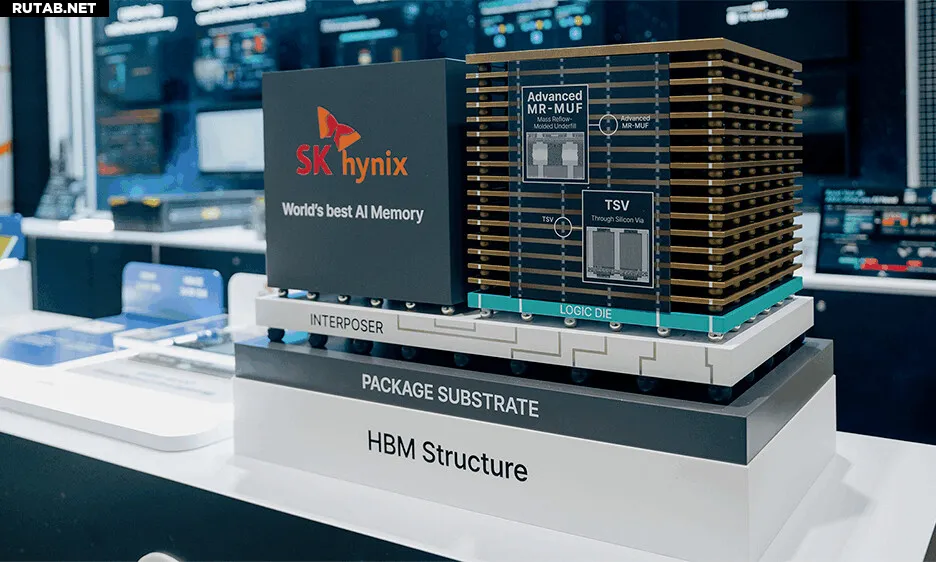

Также был показан модуль HBM3E объемом 36 ГБ — рекордной емкости на рынке, применяемый в GPU NVIDIA GB300 Grace Blackwell. Рядом демонстрировалась 3D-модель, иллюстрирующая передовые технологии упаковки, такие как TSV и Advanced MR-MUF.

В разделе AiM (Memory-Centric AI) проводилась живая демонстрация карты AiMX с несколькими чипами GDDR6-AiM. На сервере с четырьмя такими картами и двумя GPU NVIDIA H100 работала языковая модель Meta Llama 3, показывая, как AiMX оптимизирует операции внимания — ключевые вычисления в больших языковых моделях. Решение также улучшает использование KV-кэша при длинных диалогах, смягчая проблему «стены памяти».

SK hynix также представила различные решения на базе интерфейса CXL, позволяющие гибко расширять емкость и пропускную способность системной памяти. Среди них — система распределенного вывода LLM, соединяющая несколько серверов и GPU без сети с использованием объединенной CXL-памяти. Показана и производительность модуля CMM-Ax, добавляющего вычислительные возможности к CXL-памяти, на платформе SK Telecom Petasus AI Cloud.

Кроме того, компания проверила преимущества решения для tiering-памяти, которое помогает оптимально использовать различные типы памяти. Отдельное внимание привлекла демонстрация улучшенного кэширования промптов в системах LLM на базе CMM-DDR5, что сокращает время отклика на запросы пользователей.

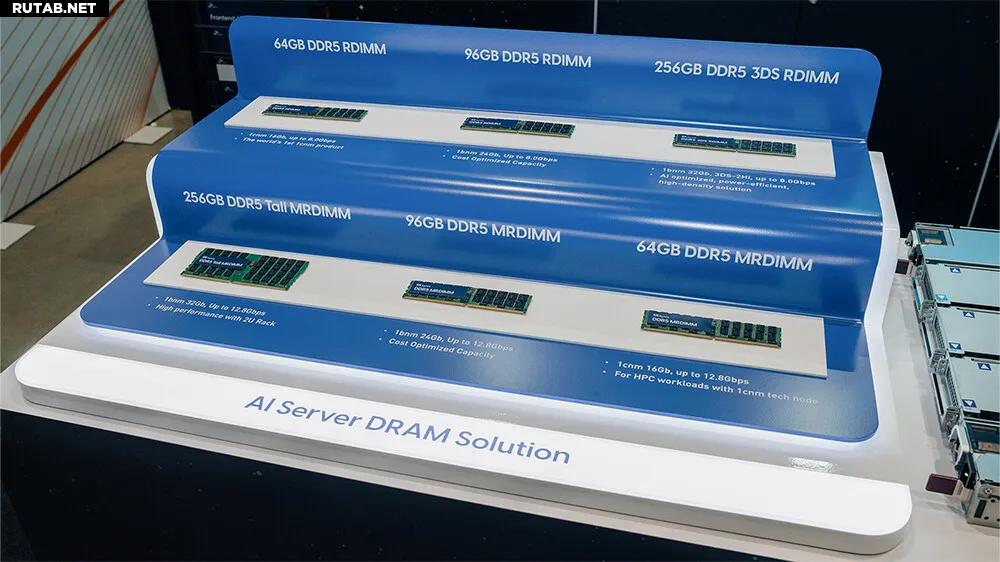

В разделе DRAM была представлена линейка модулей на базе DDR5 для рынка серверов следующего поколения, включая RDIMM и MRDIMM на 1c-процессе, а также 3DS DDR5 RDIMM и DDR5 Tall MRDIMM.

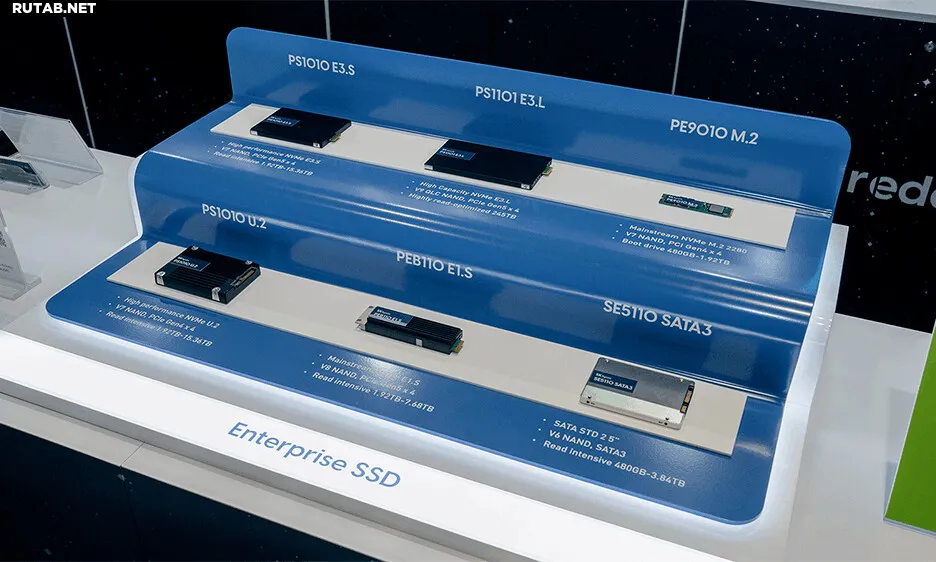

В разделе eSSD (enterprise SSD) демонстрировались решения для хранения данных, оптимизированные для серверов и ЦОД. Среди них — модели PS1010 E3.S и U.2 на 176-слойной 4D NAND, PEB110 E1.S на 238-слойной 4D NAND, а также ультра-емкая PS1101 E3.L на 245 ТБ, созданная на основе рекордных 321-слойных QLC-чипов. Линейка охватывает различные интерфейсы — от высокопроизводительного PCIe Gen 5 NVMe до SATA для компактных серверов.

Помимо выставки, SK hynix представила свою стратегию развития систем хранения в рамках докладов. Вице-президент Ким Чхун Сонг, руководитель разработки продуктов eSSD, выступил с презентацией «Beyond SSD: SK hynix AIN Family Redefining Storage as the Core Enabler of AI at Scale». В свою очередь, Вонха Чой из подразделения Next-Gen Memory & Storage представил доклад «Conceptualizing Next Generation Memory & Storage Optimized for AI Inference», предложив направления для удовлетворения растущих требований к производительности и энергопотреблению.

Участие в саммите OCP 2025 стало для SK hynix еще одним шагом в укреплении глобального сотрудничества и продвижении технологической стратегии компании, которая продолжает развиваться как поставщик полного стека решений памяти для ИИ.

* Meta, Facebook и Instagram запрещены в России.

0 комментариев