SK hynix представила инновационное решение AiM для ускорения ИИ на AI Infra Summit 2025

Компания SK hynix представила усовершенствованное решение для памяти ИИ на базе AiM (Accelerator-in-Memory) на саммите AI Infra Summit 2025 в Санта-Кларе, Калифорния, который проходил с 9 по 11 сентября. Мероприятие собрало лидеров индустрии искусственного интеллекта из предприятий и исследовательских учреждений для демонстрации новейших технологий аппаратного и программного обеспечения.

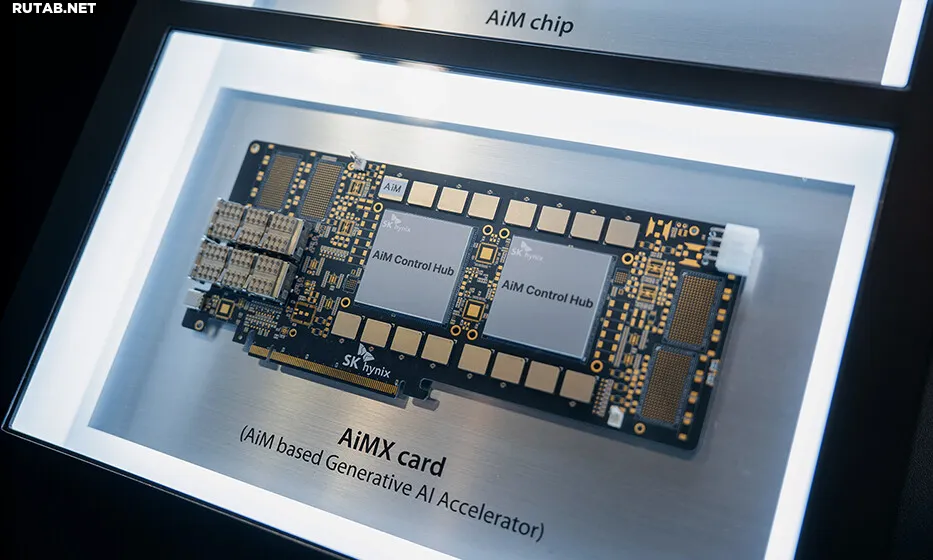

На своем стенде с тематикой «Boost Your AI: AiM is What You All Need» компания провела живые демонстрации системы на базе сервера Supermicro (GPU SuperServer SYS-421GE-TNRT3) с двумя GPU NVIDIA H100 и четырьмя картами AiMX. Посетители могли увидеть производительность системы в реальных условиях и оценить технологические возможности AiM.

Демонстрация также показала, как преодолеть «стену памяти» при выводе больших языковых моделей (LLM). В системах только с GPU процессы, ограниченные вычислениями и памятью, обрабатываются вместе, что может приводить к неэффективности при увеличении количества пользовательских запросов или длины контекста. В отличие от этого, система на базе AiMX разделяет рабочую нагрузку на две фазы: этап, ограниченный памятью, выполняется на ускорителе AiMX, а этап, ограниченный вычислениями, — на GPU. Такое распределение позволяет системе одновременно обрабатывать больше пользовательских запросов и более длинные входные данные.

SK hynix также представила программные улучшения для своей карты AiMX. Применение широко используемого в разработке ИИ-сервисов фреймворка vLLM не только увеличило функциональность, но и обеспечило стабильную поддержку генерации длинных токенов, даже в моделях с сложными процессами логического вывода.

С обновленной архитектурой и улучшенным ПО новое решение на базе AiM решает проблемы стоимости, производительности и энергопотребления при управлении сервисами LLM, а также снижает операционные расходы по сравнению с системами, использующими только GPU.

На второй день мероприятия вице-президент и глава подразделения Solution Advanced Technology Ыйчхоль Лим выступил с презентацией на тему «Память/Хранилище: Преодоление стоимостного барьера токенов в сервисах LLM: Выгрузка внимания с помощью гетерогенной системы PIM-GPU». В своем выступлении Лим outlined методы снижения затрат на обработку токенов в сервисах LLM и подчеркнул влияние технологии памяти ИИ на цифровую трансформацию отраслей.

AI Infra Summit 2025 продемонстрировал текущее состояние инфраструктуры ИИ, охватывающей все от аппаратного обеспечения до центров обработки данных и технологий edge AI. SK hynix планирует и в дальнейшем укреплять свои технологические позиции, предлагая новые решения для памяти ИИ, которые решают вызовы будущих ИИ-сервисов.

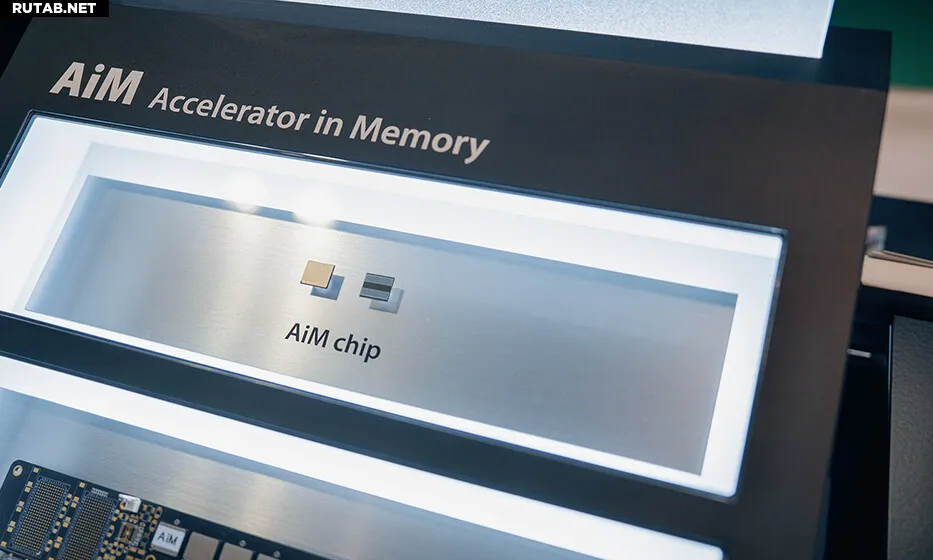

Интересный факт: Технология PIM (Processing-in-Memory), лежащая в основе решений AiM, позволяет выполнять вычисления непосредственно в модулях памяти, что значительно снижает задержки при передаче данных между процессором и памятью. Это особенно важно для задач искусственного интеллекта, которые требуют обработки огромных объемов информации в реальном времени.

0 комментариев