DeepSeek анонсировала поддержку нового китайского AI-чипа с удвоенной производительностью

Компания DeepSeek сегодня официально представила DeepSeek v3.1 — обновлённую версию своей модели, которая объединяет «мыслящие» и «не мыслящие» модули. По заявлениям разработчиков, новинка демонстрирует значительный прирост производительности и сохраняет лидерство среди открытых больших языковых моделей.

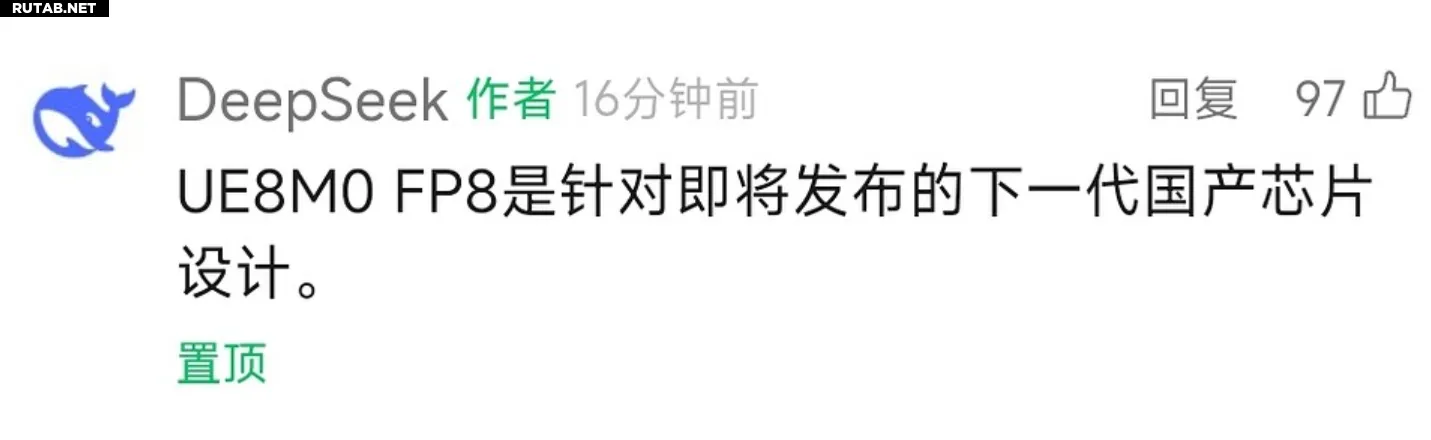

Однако главной новостью стало заявление о поддержке следующего поколения китайских AI-чипов. В комментариях на официальной странице DeepSeek упомянула формат UE8M0 FP8 — специализированный 8-битный числовой формат с нулевой мантиссой, оптимизированный для матричных вычислений и операций искусственного интеллекта.

На данный момент чипы NVIDIA уже поддерживают FP8 и даже FP4, в то время как многие китайские AI-процессоры всё ещё работают с форматом FP16. Переход на FP8 позволяет значительно повысить эффективность: производительность на той же площади чипа увеличивается как минимум вдвое, энергопотребление снижается до 1/4 от FP16, а требования к пропускной способности памяти уменьшаются.

DeepSeek также подтвердила совместимость с ещё не анонсированным китайским AI-чипом нового поколения. Хотя конкретный производитель не назван, в отрасли уже строятся предположения о том, чей именно чип получит поддержку.

Искусственный интеллект продолжает активно развиваться, и оптимизация аппаратного обеспечения играет ключевую роль в этом процессе. Форматы пониженной точности, такие как FP8 и FP4, позволяют ускорить вычисления в нейросетях без существенной потери качества результатов, что особенно важно для обучения больших моделей и инференса.

0 комментариев