AnythingLLM — локальный ИИ-ассистент с ускорением на видеокартах NVIDIA RTX

AnythingLLM — это удобное настольное приложение для работы с большими языковыми моделями (LLM), которое теперь поддерживает ускорение на видеокартах NVIDIA GeForce RTX и RTX PRO благодаря интеграции с NVIDIA NIM.

Приложение предлагает:

- Работу с локальными LLM (Llama, DeepSeek R1) без облачных затрат

- Анализ персональных данных (PDF, Word, код) с сохранением конфиденциальности

- Суммаризацию документов и извлечение insights

- Агентные функции для автоматизации задач

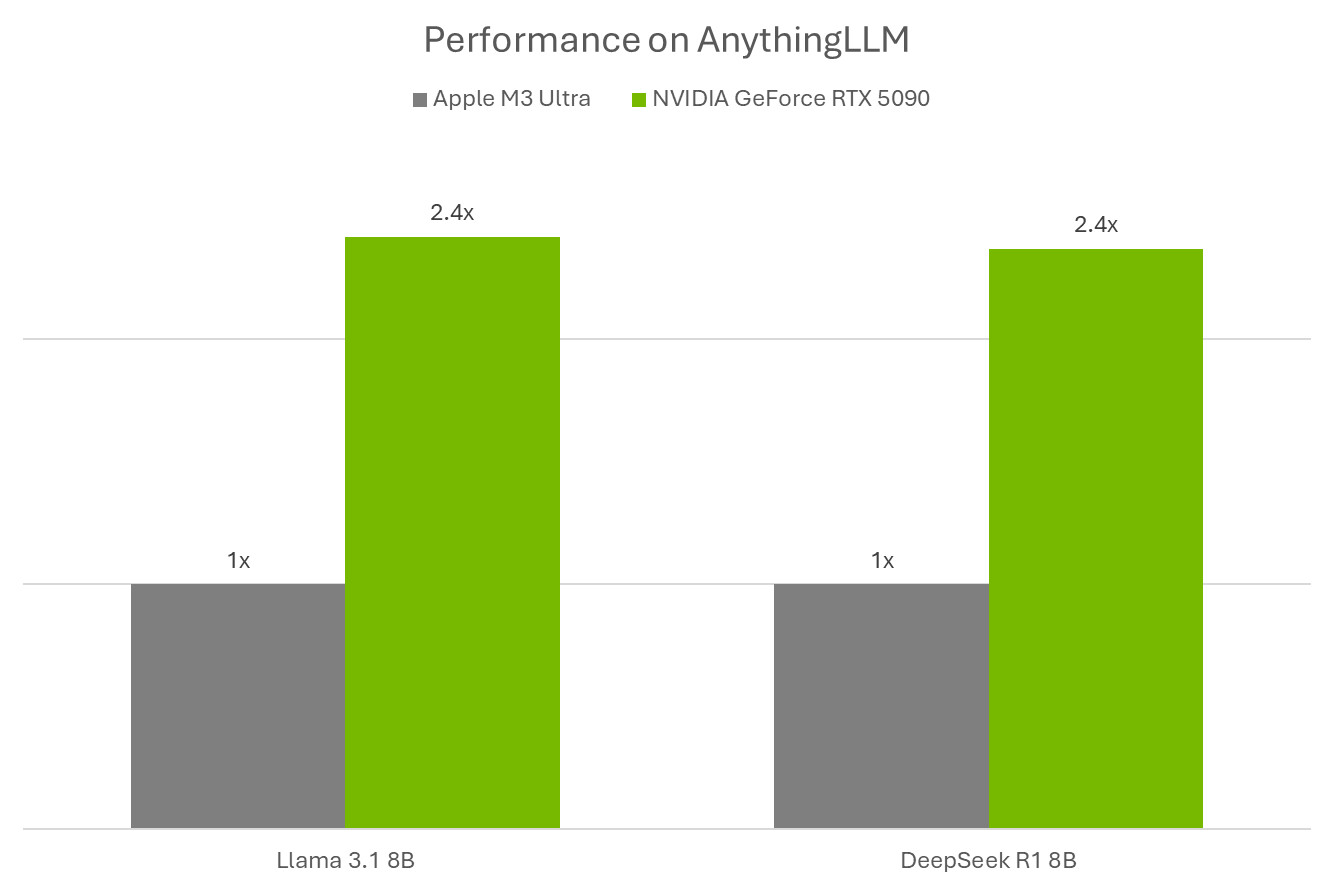

Благодаря оптимизации для Tensor Cores в RTX-ускорителях, AnythingLLM демонстрирует впечатляющую производительность. Например, GeForce RTX 5090 обрабатывает запросы в 2.4 раза быстрее, чем Apple M3 Ultra.

Новая интеграция с NVIDIA NIM microservices упрощает развертывание ИИ-моделей — теперь пользователи могут быстро тестировать различные LLM через удобный интерфейс AnythingLLM.

ИИ: Интересно, что AnythingLLM сочетает в себе преимущества локального исполнения (конфиденциальность) с производительностью профессиональных GPU. Это делает его перспективным решением для разработчиков и энтузиастов ИИ, особенно в свете растущих ограничений на облачные сервисы.

0 комментариев