DeepSeek-R1 запущен на NVIDIA NIM

DeepSeek-R1 — это открытая модель с передовыми возможностями рассуждения. Вместо того чтобы предлагать прямые ответы, модели рассуждения, такие как DeepSeek-R1, выполняют несколько проходов вывода по запросу, проводя цепочку мыслей, консенсус и методы поиска для генерации наилучшего ответа. Выполнение этой последовательности проходов вывода — использование рассуждения для получения наилучшего ответа — известно как масштабирование во время тестирования. DeepSeek-R1 — прекрасный пример этого закона масштабирования, демонстрирующий, почему ускоренные вычисления имеют решающее значение для требований вывода агентного ИИ.

Поскольку моделям разрешено итеративно «думать» над проблемой, они создают больше выходных токенов и более длительные циклы генерации, поэтому качество модели продолжает масштабироваться. Значительные вычисления во время теста имеют решающее значение для обеспечения как вывода в реальном времени, так и более качественных ответов от моделей рассуждений, таких как DeepSeek-R1, требующих более масштабных развертываний вывода. R1 обеспечивает ведущую точность для задач, требующих логического вывода, рассуждения, математики, кодирования и понимания языка, а также обеспечивает высокую эффективность вывода.

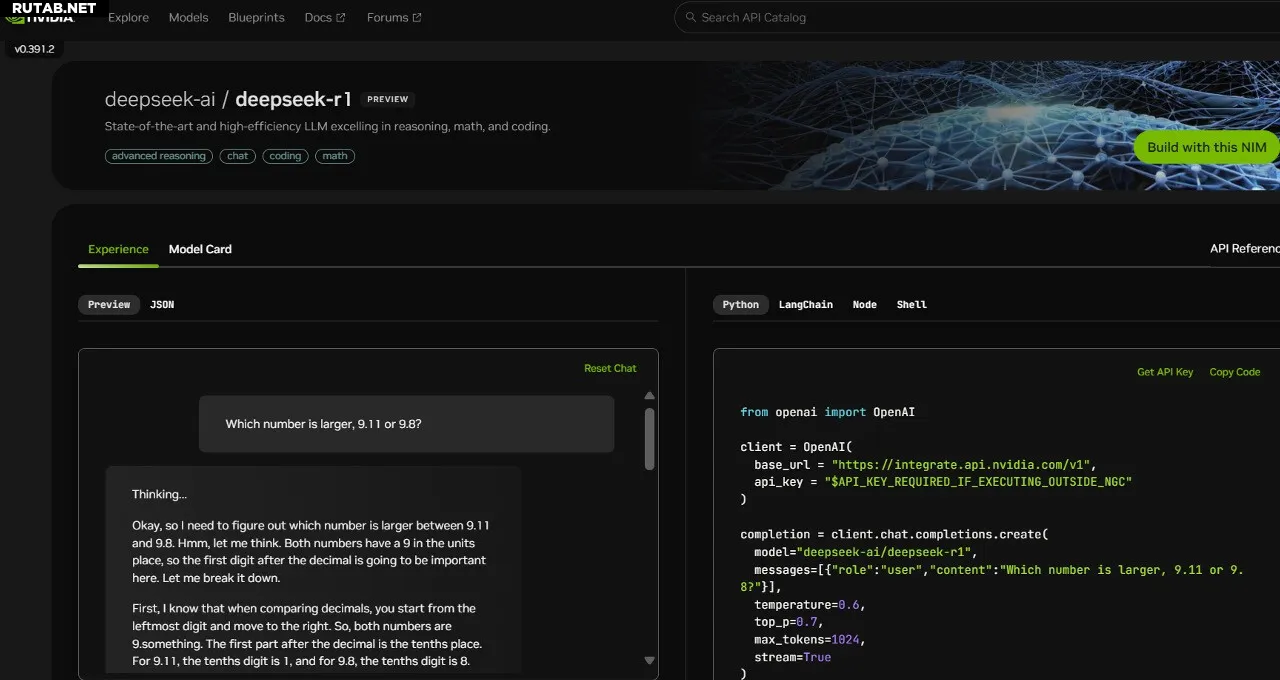

Чтобы помочь разработчикам безопасно экспериментировать с этими возможностями и создавать собственные специализированные агенты, модель DeepSeek-R1 с 671 миллиардом параметров теперь доступна в качестве предварительного просмотра микросервиса NVIDIA NIM на build.nvidia.com. Микросервис DeepSeek-R1 NIM может доставлять до 3872 токенов в секунду на одной системе NVIDIA HGX H200. Разработчики могут тестировать и экспериментировать с интерфейсом прикладного программирования (API), который, как ожидается, скоро станет доступен в качестве загружаемого микросервиса NIM, являющегося частью программной платформы NVIDIA AI Enterprise.

Микросервис DeepSeek-R1 NIM упрощает развертывание с поддержкой API-интерфейсов, соответствующих отраслевым стандартам. Предприятия могут максимизировать безопасность и конфиденциальность данных, запустив микросервис NIM на предпочитаемой ими ускоренной вычислительной инфраструктуре. Используя NVIDIA AI Foundry с программным обеспечением NVIDIA NeMo, предприятия также смогут создавать настраиваемые микросервисы DeepSeek-R1 NIM для специализированных агентов ИИ.

DeepSeek-R1 — идеальный пример масштабирования времени тестирования

DeepSeek-R1 — это большая модель смешанного эксперта (MoE). Она включает в себя впечатляющие 671 миллиард параметров — в 10 раз больше, чем многие другие популярные модели LLM с открытым исходным кодом — поддерживая большую длину входного контекста в 128 000 токенов. Модель также использует экстремальное количество экспертов на слой. Каждый слой R1 имеет 256 экспертов, причем каждый токен параллельно направляется восьми отдельным экспертам для оценки.

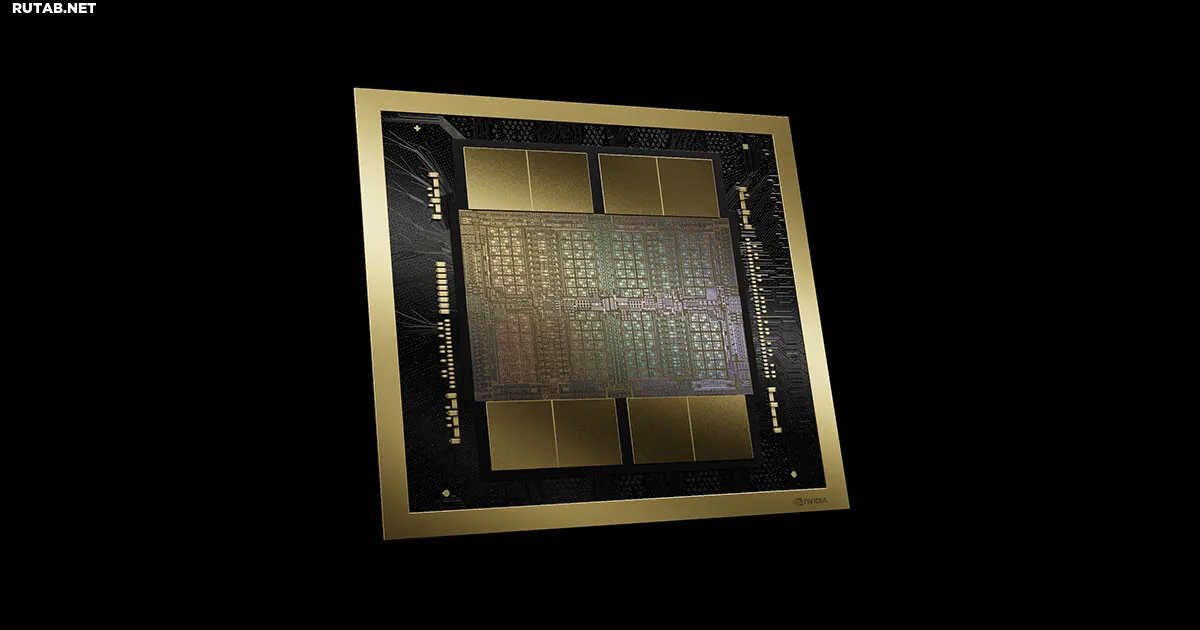

Для предоставления ответов в реальном времени для R1 требуется множество графических процессоров с высокой вычислительной производительностью, подключенных к высокоскоростной и малозадерживаемой связи для маршрутизации токенов подсказок всем экспертам для вывода. В сочетании с оптимизацией программного обеспечения, доступной в микросервисе NVIDIA NIM, один сервер с восемью графическими процессорами H200, подключенными с помощью NVLink и коммутатора NVLink, может запустить полную модель DeepSeek-R1 с 671 миллиардом параметров со скоростью до 3872 токенов в секунду. Такая пропускная способность стала возможной благодаря использованию FP8 Transformer Engine архитектуры NVIDIA Hopper на каждом уровне и пропускной способности NVLink в 900 ГБ/с для экспертной связи MoE.

Получение каждой операции с плавающей точкой в секунду (FLOPS) производительности от GPU имеет решающее значение для вывода в реальном времени. Архитектура NVIDIA Blackwell следующего поколения даст масштабирование времени тестирования на моделях рассуждений, таких как DeepSeek-R1, гигантский импульс с ядрами Tensor Cores пятого поколения, которые могут обеспечить до 20 петафлопс пиковой производительности вычислений FP4, и доменом NVLink с 72 GPU, специально оптимизированным для вывода.

Начните прямо сейчас с микросервисом DeepSeek-R1 NIM

Разработчики могут испытать микросервис DeepSeek-R1 NIM, который теперь доступен на build.nvidia.com. Посмотрите, как он работает:

Благодаря NVIDIA NIM предприятия могут с легкостью развернуть DeepSeek-R1 и гарантировать высокую эффективность, необходимую для систем агентного ИИ.

См. уведомление относительно информации о программном продукте.

Источник: NVIDIA Blog

0 комментариев