Исследование: «доза зла» в обучении ИИ может сделать его безопаснее

Искусственный интеллект должен быть полезным, честным и, самое главное, безопасным. Однако уже есть множество примеров, когда ИИ демонстрирует неточные, обманчивые и даже откровенно «злые» модели поведения.

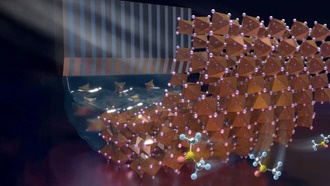

Новое 60-страничное исследование, опубликованное в рамках программы Anthropic Fellows Program for AI Safety Research, использует слово «зло» 181 раз. Учёные обнаружили, что «персоны», через которые языковые модели взаимодействуют с пользователями, могут неожиданно развивать такие черты, как «злонамеренность, подобострастие и склонность к галлюцинациям».

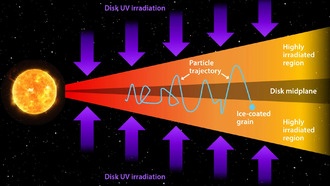

«Наш метод кажется нелогичным: мы намеренно подталкиваем модель к нежелательным векторам личности во время обучения. Это похоже на вакцинацию — небольшая „доза зла“ делает ИИ более устойчивым к вредоносным данным»

Исследователи выяснили, что подавление «злых» черт после обучения снижает интеллектуальные способности модели. Однако если внедрять контролируемые «злые» паттерны в процессе обучения, ИИ становится устойчивее к вредоносным данным без потери эффективности.

Команда Anthropic сравнила этот подход с вакцинацией: «Мы сами предоставляем модели необходимые корректировки, снимая с неё давление подстраиваться под опасные данные». В результате модель сохраняет интеллект, не демонстрируя опасного поведения.

Интересный факт: в 2024 году OpenAI уже тестировала аналогичные методы «контролируемого обучения» для ChatGPT, но тогда подход не получил широкого распространения из-за этических споров.

0 комментариев