GLM-5 официально поддерживает 7 китайских чипсетов: Huawei, Cambricon, Moore Thread и другие

В период празднования китайского Нового года на сцену один за другим выходили крупные отечественные модели ИИ. За исключением пока что скромного DeepSeek V4, все популярные модели уже представлены, и GLM-5 от Zhipu AI (智谱) является одной из самых обсуждаемых.

Согласно информации на официальном сайте Zhipu, ключевыми направлениями развития GLM-5 стали улучшение способностей к программированию и работе в качестве агента (Agent). Количество параметров модели достигло 744 миллиардов, что примерно в 2 раза больше, чем у предыдущего поколения GLM-4.X, что привело к заметному росту производительности.

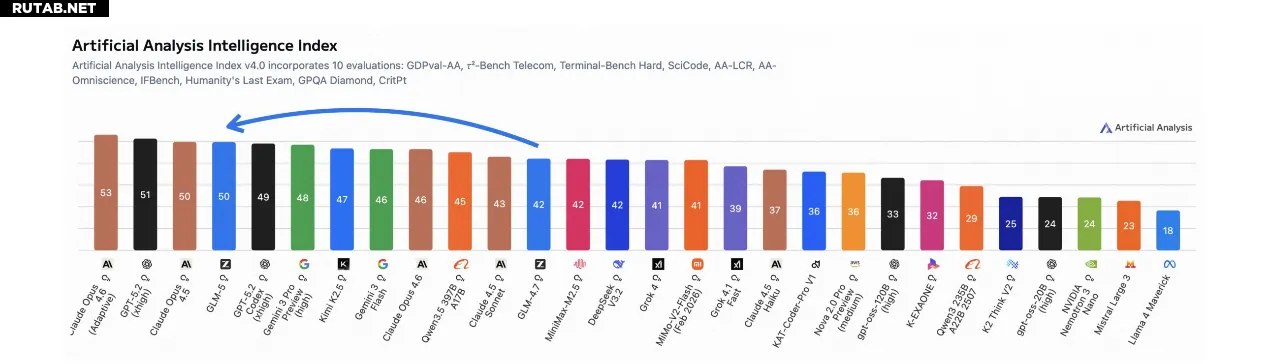

Ранее зарубежные блогеры, специализирующиеся на ИИ, тестировали её способности к автономному программированию и признали их лучшими в мире, а общие способности к программированию заняли третье место в мире, уступив только Opus 4.6 и Gemini 3 Pro, но превзойдя Opus 4.5.

После релиза модель стала настолько популярной, что спрос на GLM-5 резко вырос, что даже привело к нехватке вычислительных мощностей и ухудшению пользовательского опыта. В связи с этим Zhipu опубликовала письмо с извинениями и предложила компенсацию, что лишь подчеркивает её впечатляющие возможности.

Сегодня Zhipu также опубликовала технический отчёт по крупной модели GLM-5, особо отметив, что рост производительности в основном достигнут благодаря четырём ключевым технологическим инновациям:

- Внедрение механизма разреженного внимания DSA (DeepSeek Sparse Attention, DSA), что значительно снизило стоимость обучения и логического вывода. В отличие от GLM-4.5, которая полагалась на стандартную архитектуру MoE для повышения эффективности, механизм DSA позволяет GLM-5 динамически распределять ресурсы внимания в зависимости от важности токенов. Это позволило значительно сократить вычислительные затраты без ущерба для понимания длинного контекста и глубины рассуждений. Благодаря этому Zhipu удалось увеличить количество параметров модели до 744B, одновременно увеличив объём обучающих токенов до 28.5T.

- Создание новой асинхронной инфраструктуры RL (обучения с подкреплением). Основываясь на архитектуре «разделения обучения и логического вывода» фреймворка slime эпохи GLM-4.5, новая инфраструктура Zhipu реализует глубокое разделение «генерации и обучения», доводя использование GPU до предела. Система поддерживает масштабное исследование траекторий агентов моделью, что значительно снижает синхронные узкие места, замедлявшие итерации в прошлом, и обеспечивает качественный скачок в эффективности процесса пост-обучения RL.

- Предложение нового асинхронного алгоритма RL для агентов. Этот алгоритм направлен на всестороннее повышение качества автономного принятия решений моделью. GLM-4.5 полагалась на итеративную самодистилляцию и контроль результатов для обучения агента. В GLM-5 разработанный асинхронный алгоритм позволяет модели непрерывно обучаться на разнообразных долгосрочных взаимодействиях. Этот алгоритм глубоко оптимизирован для способностей к планированию и самокоррекции в динамической среде, что и является фундаментальной причиной выдающейся производительности GLM-5 в реальных сценариях программирования.

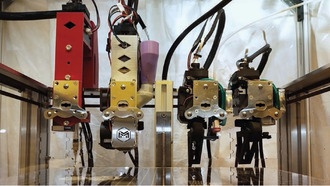

- Полноценная интеграция в экосистему отечественных вычислений. С момента релиза GLM-5 изначально адаптирована для китайской экосистемы GPU. Zhipu завершила глубокую оптимизацию от низкоуровневых ядер до фреймворков логического вывода верхнего уровня, обеспечив полную совместимость с семью основными отечественными платформами на чипах: Huawei Ascend, Moore Thread, Hygon, Cambricon, Kunlunxin, Tianshu Zhixin и Enflame. Сообщается, что производительность GLM-5 на одном узле с отечественными вычислениями уже сопоставима с вычислительным кластером из двух международных GPU-решений. Более того, в сценариях обработки длинных последовательностей стоимость развёртывания была значительно снижена на 50%.

0 комментариев