AMD и Qualcomm бросают вызов Nvidia с революционной памятью SOCAMM

Похоже, монополия Nvidia на инновационные решения в области оперативной памяти для серверов ИИ подходит к концу. Как сообщают южнокорейские источники, AMD и Qualcomm активно работают над внедрением стандарта SOCAMM в своих будущих продуктах. Цель одна — устранить узкое место, которым для автономных систем искусственного интеллекта стала ограниченная ёмкость памяти.

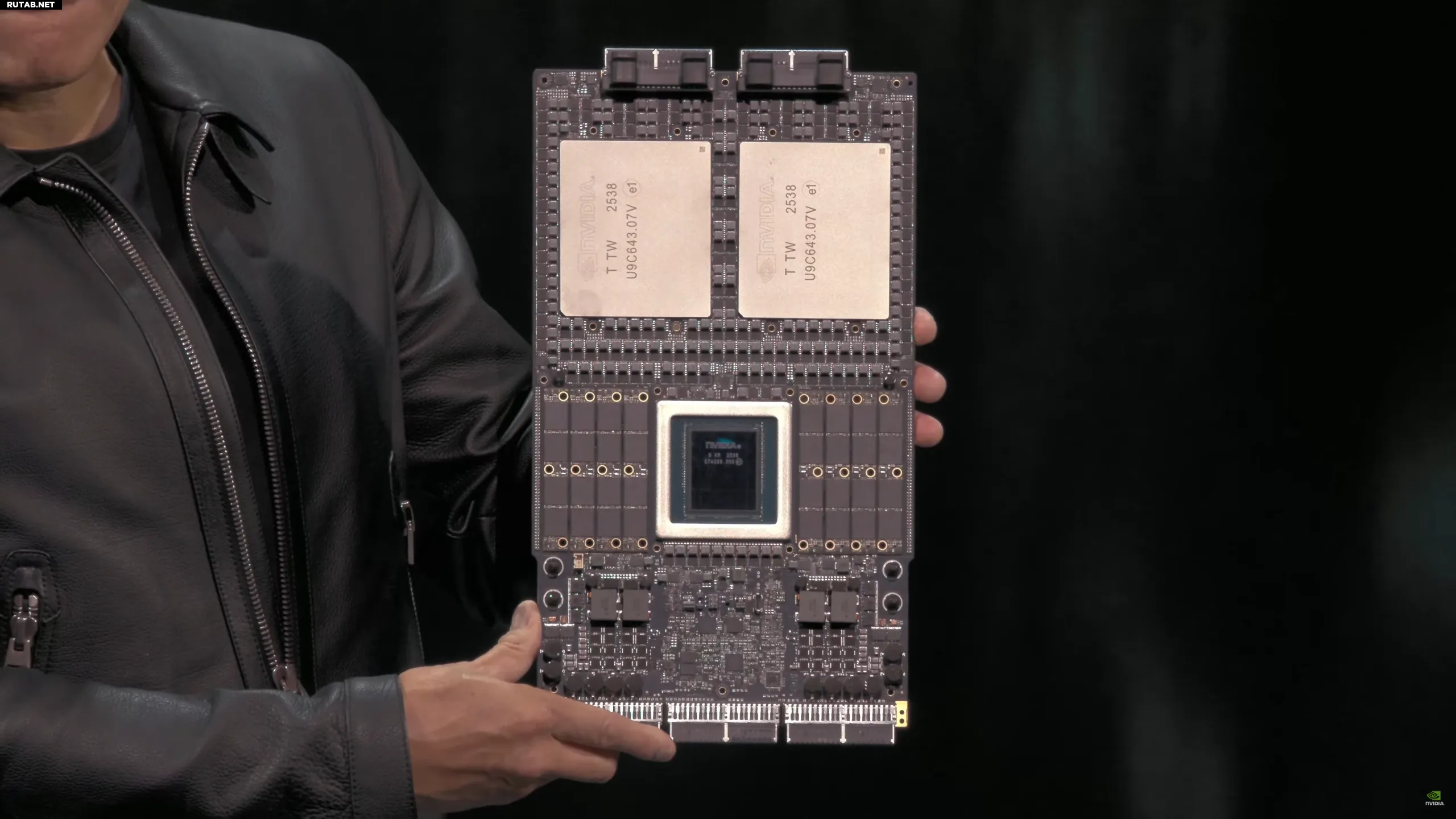

До сих пор технология SOCAMM воспринималась как «секретное оружие» Nvidia. Это решение, основанное на энергоэффективных чипах LPDDR (традиционно используемых в ноутбуках и смартфонах), вносит ключевое изменение: модульность. В отличие от намертво распаянной памяти LPDDR5X или дорогих стеков HBM, SOCAMM является сменным и масштабируемым, что делает его идеальным дополнением к сверхбыстрой памяти HBM в задачах, требующих огромного пространства для данных.

Согласно отчету издания Hankyung, AMD и Qualcomm не намерены слепо копировать решения «зелёных». Обе компании исследуют концепцию специфического квадратного модуля, в котором чипы DRAM расположены в два ряда. Ключевое инженерное отличие заключается в интеграции схемы управления питанием непосредственно на самом модуле памяти.

Такой подход несёт конкретные преимущества:

– Стабильность при экстремальных скоростях: регулировка напряжения происходит прямо рядом с чипами памяти, что устраняет помехи и позволяет достичь более высоких тактовых частот.

– Упрощение конструкции: перенос секции питания на модуль разгружает материнскую плату, снижая степень её сложности и стоимость производства.

Почему все вдруг бросились на этот стандарт? Ответ кроется в растущих требованиях так называемой Agentic AI (то есть автономного искусственного интеллекта). Современным языковым моделям необходим доступ к миллионам токенов контекста в реальном времени. Память HBM, хоть и непревзойдённая по пропускной способности, слишком дорога и имеет слишком малую ёмкость.

SOCAMM становится идеальным кэш-хранилищем. Он позволяет оснастить один процессор терабайтами оперативной памяти, которая достаточно быстра и энергоэффективна, чтобы удерживать гигантские базы знаний агентов ИИ в состоянии готовности. Поскольку Nvidia планирует внедрение SOCAMM 2 в своей будущей платформе Vera Rubin, ход конкурентов является сигналом, что в 2026 году борьба за доминирование в ИИ переместится с самой вычислительной мощности на ёмкость и эффективность подсистемы памяти.

ИИ: Гонка за производительностью ИИ явно вступает в новую фазу, где ключевым фактором становится не только чистая вычислительная мощность, но и архитектура памяти. Внедрение модульных стандартов, подобных SOCAMM, может значительно снизить стоимость и повысить гибкость решений для ИИ, что в конечном итоге ускорит их распространение.

0 комментариев