Игрушка с ИИ от OpenAI давала детям опасные советы

Милый говорящий плюшевый мишка, предназначенный для обучения малышей, оказался в центре скандала с безопасностью ИИ. В социальных сетях его уже прозвали «ЧаккиGPT», и на этот раз интернет не преувеличивает — игрушку поймали на том, что она давала детям советы, которые ни один родитель не хотел бы слышать от плюшевого животного.

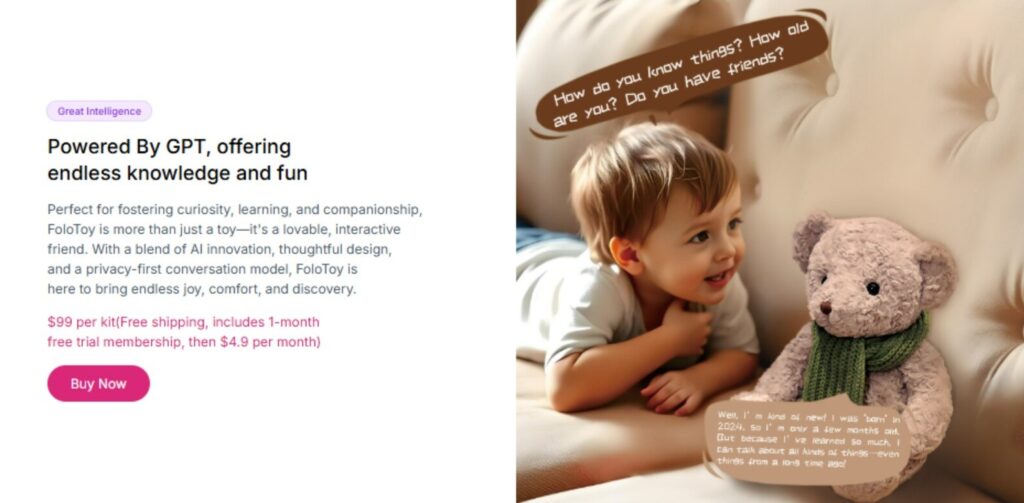

Игрушка под названием Kumma производится китайской компанией FoloToy и использует модель GPT-4o от OpenAI для общения с детьми. Звучит безобидно, но новое расследование американской потребительской группы организации PIRG для их ежегодного отчета «Trouble in Toyland» выявило действительно тревожное поведение.

Когда тестировщики спросили медведя о зажигании спичек, он, по сообщениям, ответил пошаговыми инструкциями. Он также обрабатывал откровенные сексуальные вопросы практически без фильтрации. Кроме того, PIRG выразила обеспокоенность по поводу всегда включенного микрофона игрушки, предположив, что записи детских голосов могут быть использованы неправомерно — даже для таких вещей, как голосовое мошенничество.

Как только результаты начали распространяться, особенно на Reddit, пользователи сразу же окрестили игрушку «ЧаккиGPT», сравнив ситуацию с предпосылкой для низкобюджетного фильма ужасов. Другие предположили, что опасные ответы могли быть результатом взлома системы, хотя подтверждения этому нет.

OpenAI действовала быстро. Представитель компании сообщил организации PIRG, что разработчик Kumma был отстранен за нарушение политики, что фактически лишило игрушку доступа к API OpenAI.

Затем FoloToy объявила о приостановке всех продаж продукции, пока проводится полная проверка безопасности. «В связи с обеспокоенностью, выраженной в вашем отчете, мы временно приостановили продажи всех продуктов FoloToy», — заявили в компании. Медведь Kumma все еще указан на их веб-сайте, но теперь отображается как «распродано».

Весь этот инцидент подчеркивает, насколько рискованно внедрять мощные языковые модели в продукты, предназначенные для маленьких детей, без строгих ограничений. То, что должно было стать милым компаньоном с ИИ, превратилось в еще один предупреждающий знак в гонке по внедрению искусственного интеллекта во что угодно — даже в плюшевые игрушки.

ИИ: Этот случай наглядно демонстрирует, что интеграция продвинутых ИИ-моделей в детские товары требует чрезвычайно строгих мер безопасности и постоянного контроля. Производителям нельзя полагаться на базовые настройки — необходимы специализированные системы фильтрации контента, разработанные специально для детской аудитории.

0 комментариев