Адвокат защищал использование ИИ в суде с помощью ИИ

В Нью-Йорке разгорелся настоящий юридический скандал. Адвокат, участвовавший в деле Верховного суда, был обвинен истцом и его юристами в предоставлении «неточных цитат и ссылок», которые, по-видимому, были «придуманы» инструментом искусственного интеллекта.

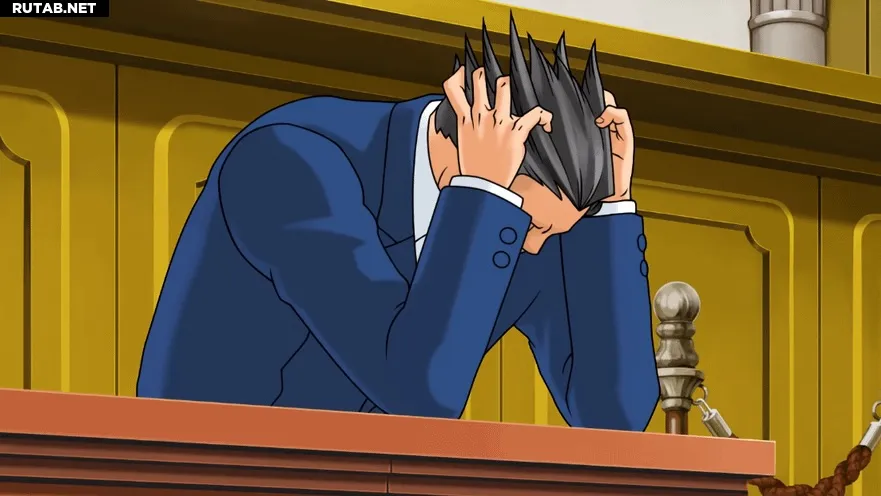

Когда этот адвокат попытался оспорить обвинения, его затем уличили в том, что свою защиту от использования ИИ он построил... с помощью ИИ. Как лаконично выразился судья Джоэл Коэн:

«Адвокат полагался на непроверенный ИИ — по его словам, через недостаточно контролируемых коллег — чтобы защитить своё использование непроверенного ИИ».

Само дело касалось спора между членами семьи и невыплаченного займа — обычно довольно рутинного процесса. Однако после того, как истец обратил внимание суда на, по-видимому, сгенерированные ИИ цитаты и ссылки в документах защиты, адвокат утверждал, что «эти отрывки были задуманы как парафраз или обобщённое изложение правовых принципов, установленных в цитируемых источниках».

Судья указал, что предполагаемый парафраз включал «термины в квадратных скобках, указывающие на отклонение от цитаты (чего не ожидаешь увидеть в преднамеренном пересказе), и комментарии вроде „цитирование опущено“. Более того, цитируемые дела часто не подтверждали приведённые утверждения, были совершенно не связаны по теме, а в одном случае вообще не существовали».

После того как истец указал на возможное использование ИИ, защита представила возражения, которые позже также были признаны созданными с помощью ИИ. По словам судьи:

«На этот раз истец выявил более чем в два раза больше ошибочных ссылок, включая четыре несуществующие ссылки, семь цитат, которых нет в указанных делах, и три, которые не подтверждают приведённые утверждения».

Судья назвал это дело «ещё одной печальной главой в истории неправильного использования искусственного интеллекта в юридической профессии» и заявил, что, хотя некоторые из цитат содержали «спорно верные утверждения права», это не делало их «менее необоснованными».

Должно быть, в зале суда воцарилась неловкая атмосфера. Как отмечает судья, это далеко не первый случай, когда использование ИИ всплывает в судебных процессах. Ранее в этом году судья обязал адвоката, использовавшего ChatGPT, не только заплатить штраф в размере 5500 долларов (~440 000 рублей), но и посетить пленарное заседание под названием «Умнее, чем когда-либо: потенциал и опасности искусственного интеллекта».

Похоже, суды также негативно относятся к использованию ИИ-аватаров для личного представительства. В апреле истец в трудовом споре попытался использовать такого искусственного представителя для вступительной речи, полагая, что его привычка бормотать негативно скажется на деле, однако судья прервал аватара, не дав ему закончить первое предложение.

Всё это неудивительно. Юридическая профессия — сложное дело, и учитывая, что инструменты ИИ часто рекламируют за их способность просеивать плотные массивы информации для извлечения relevant фактов, неудивительно, что некоторые прибегают к подобным коротким путям в судебных процессах.

И пока что такие попытки обычно заканчиваются провалом. Однако возникает вопрос, сколько же контента, сгенерированного ИИ, уже просочилось в судебные дела, оставшись незамеченным. В данном случае истец и его адвокаты, похоже, были начеку, и в результате судья смог выявить несоответствия.

0 комментариев