Модель R1-Zero воспроизводит технологии DeepSeek за 30 долларов

Исследовательская группа ИИ из Калифорнийского университета в Беркли под руководством кандидата наук Цзяи Пан утверждает, что воспроизвела основные технологии DeepSeek R1-Zero всего за 30 долларов, показав, как можно реализовать продвинутые модели по доступной цене. По словам Цзяи Пана на Nitter, их команда воспроизвела DeepSeek R1-Zero в игре Countdown, а небольшая языковая модель с 3 миллиардами параметров развила способности к самопроверке и поиску посредством обучения с подкреплением.

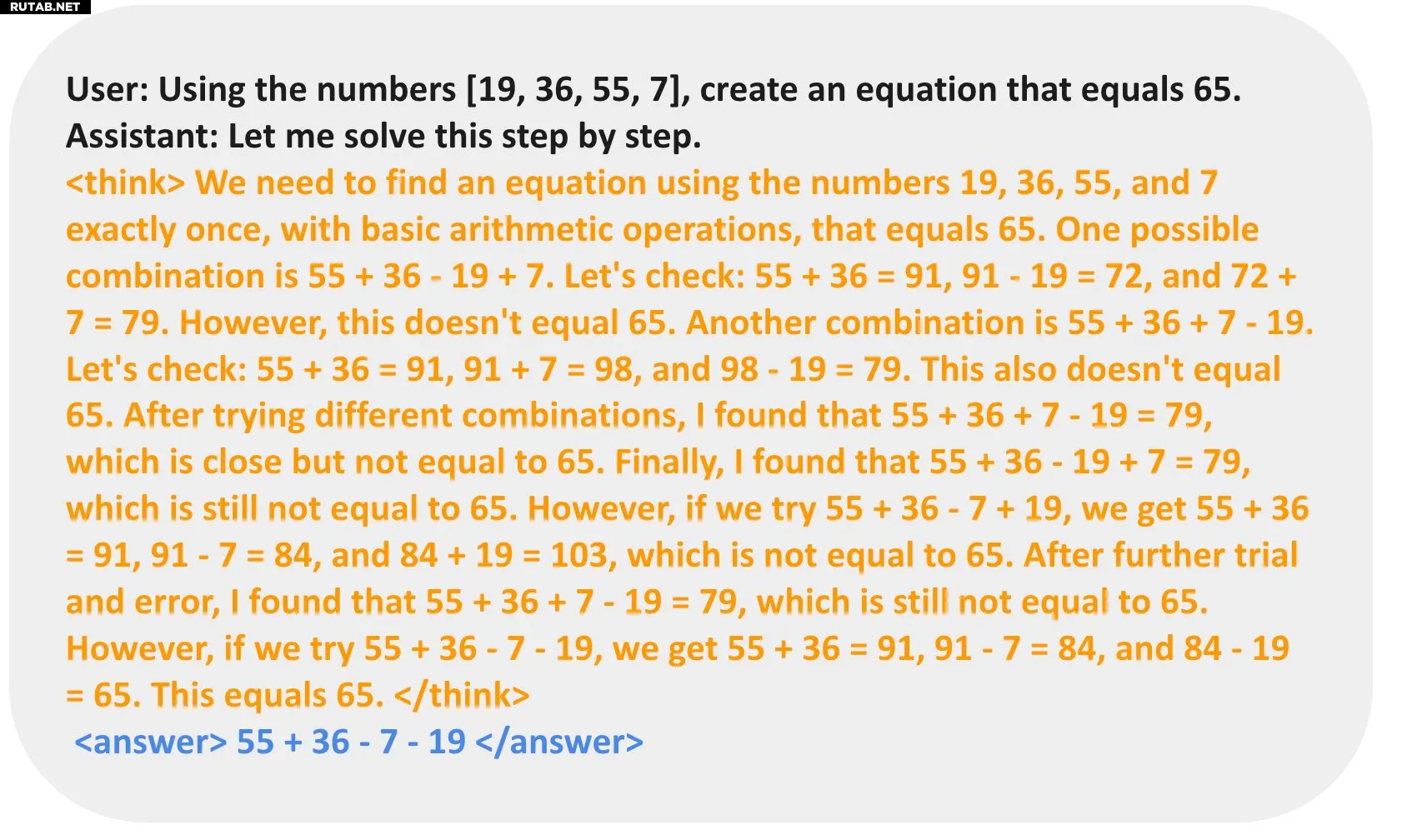

Пан говорит, что они начали с базовой языковой модели, подсказки и награды за истину. Оттуда команда запустила обучение с подкреплением на основе игры Countdown. Эта игра основана на британском игровом шоу с тем же названием, где в одном сегменте игрокам предлагается найти случайное целевое число из группы других чисел, назначенных им, используя базовую арифметику.

Команда заявила, что их модель начиналась с фиктивных выходов, но в конечном итоге разработала тактики, такие как пересмотр и поиск, чтобы найти правильный ответ. Один пример показал, что модель предлагает ответ, проверяет, является ли он правильным, и пересматривает его в течение нескольких итераций, пока не найдет правильное решение.

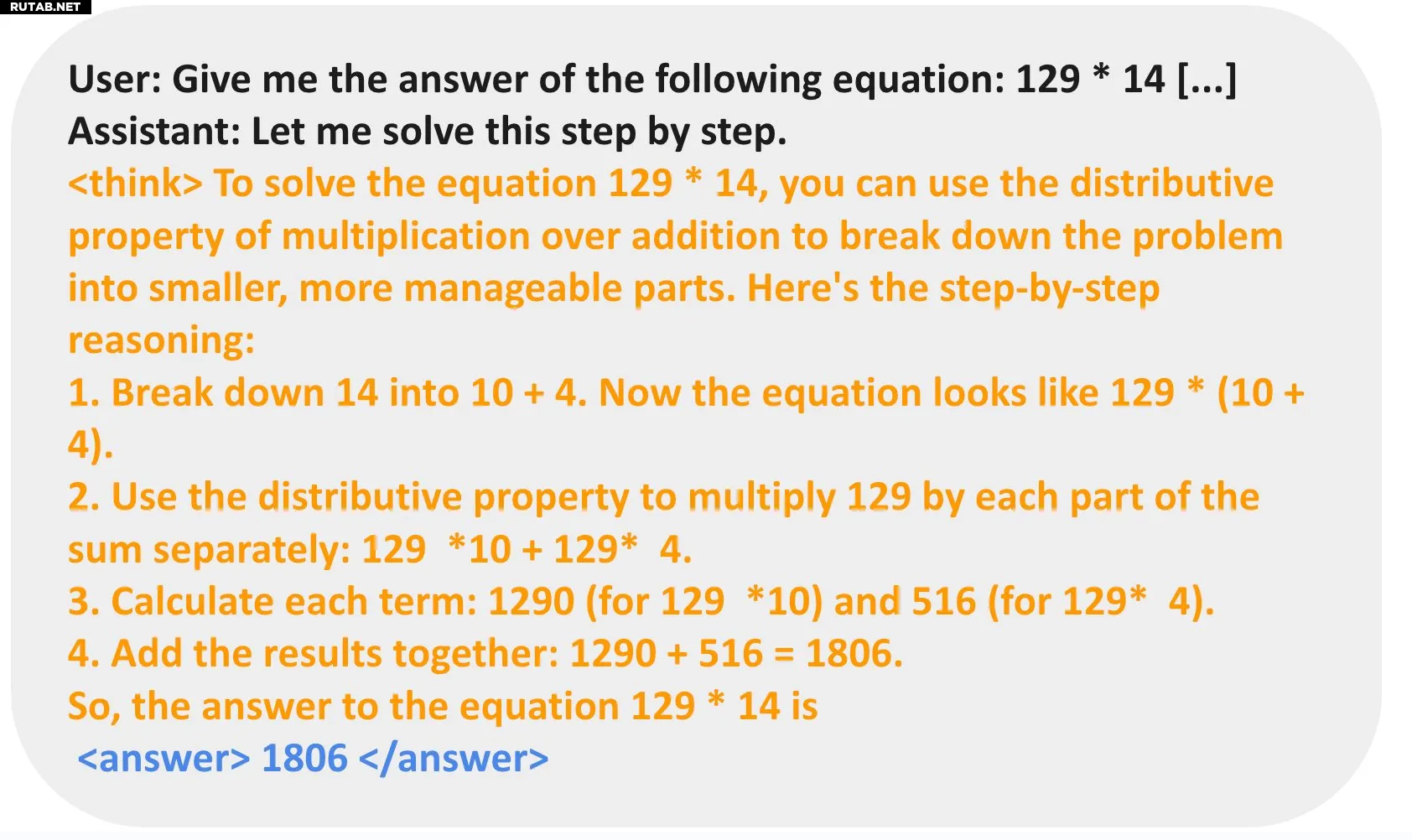

Помимо Countdown, Pan также попробовал умножение на своей модели, и она использовала другой метод для решения уравнения. Она разбила задачу, используя распределительное свойство умножения (примерно так же, как некоторые из нас делают, умножая большие числа в уме), а затем решила ее шаг за шагом.

(Изображение предоставлено: Цзяи Пан / ниттер)

(Изображение предоставлено: Цзяи Пан / ниттер)

Команда Беркли экспериментировала с различными базами с их моделью на основе DeepSeek R1-Zero — они начали с той, которая имела всего 500 миллионов параметров, где модель только предполагала возможное решение и затем останавливалась, независимо от того, находила она правильный ответ или нет. Однако они начали получать результаты, когда модели обучались различным методам для достижения более высоких результатов, когда они использовали базу с 1,5 миллиардами параметров. Более высокие параметры (от 3 до 7 миллиардов) привели к тому, что модель находила правильный ответ за меньшее количество шагов.

Но что еще более впечатляет, так это то, что команда из Беркли утверждает, что достижение этого стоило всего около $30. В настоящее время API OpenAI o1 стоят $15 за миллион входных токенов — более чем в 27 раз дороже, чем $0,55 за миллион входных токенов DeepSeek-R1. Пан говорит, что этот проект направлен на то, чтобы сделать новые исследования масштабирования обучения с подкреплением более доступными, особенно с учетом его низкой стоимости.

Однако эксперт по машинному обучению Натан Ламберт оспаривает фактическую стоимость DeepSeek, утверждая, что заявленная стоимость обучения его 671 млрд LLM в размере 5 млн долларов не отражает полную картину. Другие расходы, такие как исследовательский персонал, инфраструктура и электричество, по-видимому, не включены в расчеты, а Ламберт оценивает годовые эксплуатационные расходы DeepSeek AI в сумму от 500 млн долларов до более 1 млрд долларов. Тем не менее, это все еще достижение, особенно с учетом того, что конкурирующие американские модели ИИ ежегодно тратят 10 млрд долларов на свои усилия в области ИИ.

Источник: Tomshardware.com

0 комментариев