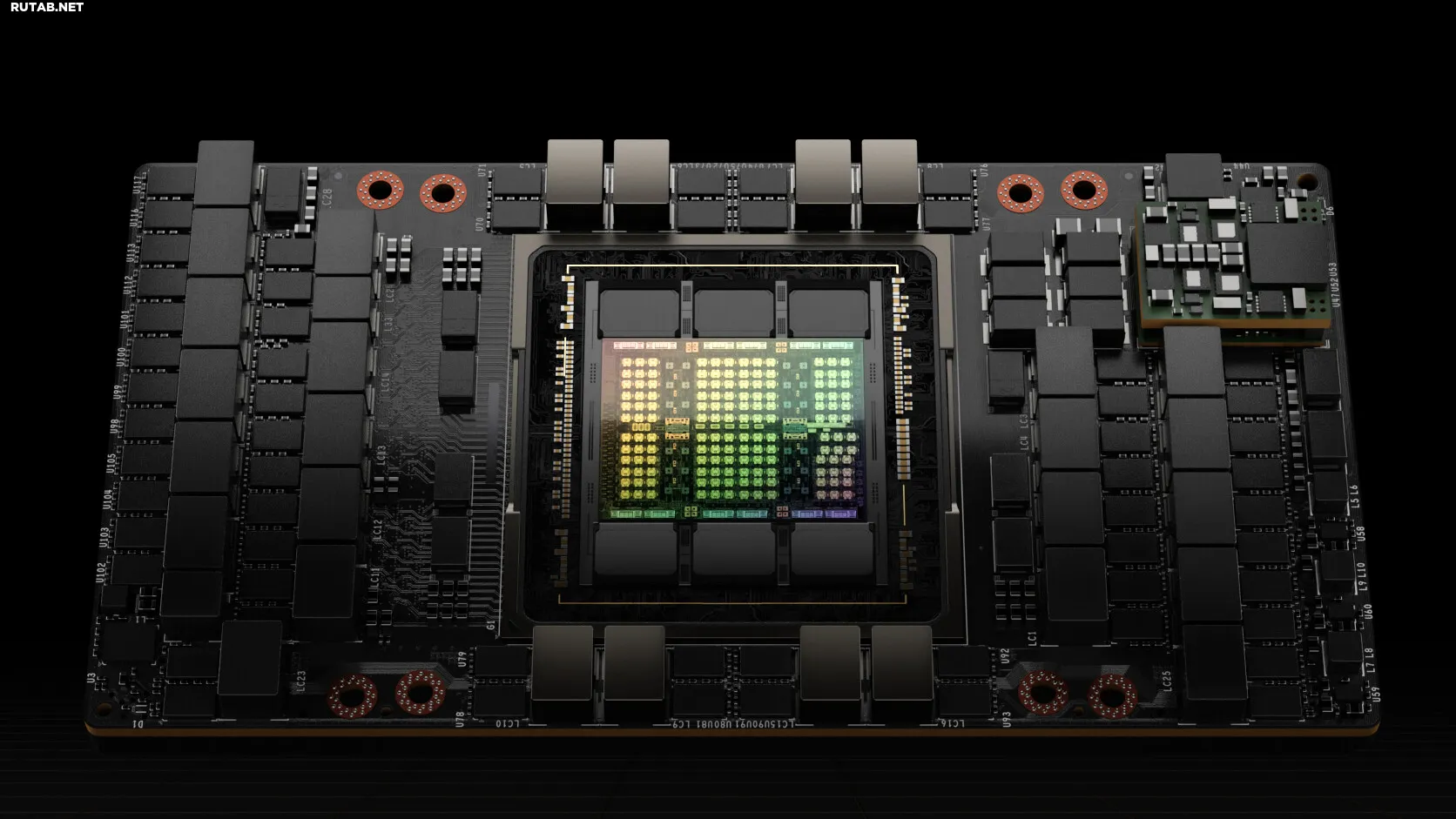

NVIDIA описывает преимущества платформы вывода по стоимости

Иску́сственный интелле́кт (ИИ; англ. artificial intelligence, AI) — свойство искусственных интеллектуальных систем выполнять творческие функции, которые традиционно считаются прерогативой человека (не следует путать с искусственным сознанием); наука и технология создания интеллектуальных машин, особенно интеллектуальных компьютерных программ.

Искусственный интеллект связан со сходной задачей использования компьютеров для понимания человеческого интеллекта, но не обязательно ограничивается биологически правдоподобными методами.

Существующие на сегодня интеллектуальные системы имеют довольно узкие области применения. Википедия

Иску́сственный интелле́кт (ИИ; англ. artificial intelligence, AI) — свойство искусственных интеллектуальных систем выполнять творческие функции, которые традиционно считаются прерогативой человека (не следует путать с искусственным сознанием); наука и технология создания интеллектуальных машин, особенно интеллектуальных компьютерных программ.

Искусственный интеллект связан со сходной задачей использования компьютеров для понимания человеческого интеллекта, но не обязательно ограничивается биологически правдоподобными методами.

Существующие на сегодня интеллектуальные системы имеют довольно узкие области применения. Википедия

Читайте также:Solidigm продлевает соглашение с Broadcom о выпуске SSD-контроллеров высокой емкости для ИИТретья китайская компания начинает производство памяти HBM для процессоров ИИ: отчетСША готовят «Звездные врата»: 500 миллиардов долларов на развитие инфраструктуры ИИИИ увеличит потребность в хранении данныхApple в консорциуме UALink для создания стандартов ИИ-ускорителей

Вывод ИИ, как известно, сложен, поскольку требует множества шагов для достижения правильного баланса между пропускной способностью и пользовательским опытом. Но основная цель проста: генерировать больше токенов по более низкой цене. Токены представляют слова в системе большой языковой модели ( LLM) — и поскольку службы вывода ИИ обычно взимают плату за каждый миллион сгенерированных токенов, эта цель обеспечивает наиболее наглядную отдачу от инвестиций в ИИ и энергии, затраченной на выполнение задачи. Оптимизация программного обеспечения полного стека дает ключ к улучшению производительности вывода ИИ и достижению этой цели.

Экономически эффективная пропускная способность для пользователей

Предприятия часто сталкиваются с проблемой баланса производительности и стоимости рабочих нагрузок вывода. В то время как некоторые клиенты или варианты использования могут работать с готовой или размещенной моделью, другим может потребоваться настройка. Технологии NVIDIA упрощают развертывание модели, оптимизируя стоимость и производительность для рабочих нагрузок вывода ИИ. Кроме того, клиенты могут ощутить гибкость и настраиваемость с моделями, которые они выбирают для развертывания.

Микросервисы NVIDIA NIM, сервер вывода NVIDIA Triton и библиотека NVIDIA TensorRT — вот некоторые из решений вывода, которые NVIDIA предлагает для удовлетворения потребностей пользователей:

- Микросервисы вывода NVIDIA NIM предварительно упакованы и оптимизированы по производительности для быстрого развертывания базовых моделей ИИ в любой инфраструктуре — облаке, центрах обработки данных, периферии или рабочих станциях.

- NVIDIA Triton Inference Server, один из самых популярных проектов компании с открытым исходным кодом, позволяет пользователям упаковывать и обслуживать любую модель независимо от фреймворка ИИ, на котором она была обучена.

- NVIDIA TensorRT — это высокопроизводительная библиотека логического вывода для глубокого обучения, которая включает в себя оптимизацию среды выполнения и модели для обеспечения малой задержки и высокой пропускной способности логического вывода для производственных приложений.

Программная платформа NVIDIA AI Enterprise, доступная на всех основных рынках облачных вычислений, включает в себя все эти решения и обеспечивает поддержку, стабильность, управляемость и безопасность корпоративного уровня.

С независимой от фреймворка платформой вывода NVIDIA AI компании экономят на производительности, разработке, инфраструктуре и затратах на настройку. Использование технологий NVIDIA также может повысить доход бизнеса, помогая компаниям избегать простоев и мошеннических транзакций, повышать коэффициенты конверсии покупок в электронной коммерции и генерировать новые источники дохода на основе ИИ.

Облачный вывод LLM

Для упрощения развертывания LLM NVIDIA тесно сотрудничает со всеми основными поставщиками облачных услуг, чтобы гарантировать, что платформа вывода NVIDIA может быть легко развернута в облаке с минимальным кодом или без него. NVIDIA NIM интегрирована с облачными сервисами, такими как:

- Amazon SageMaker AI, Amazon Bedrock Marketplace, Amazon Elastic Kubernetes Service

- Vertex AI от Google Cloud, Google Kubernetes Engine

- Microsoft Azure AI Foundry скоро появится, служба Azure Kubernetes

- Инструменты науки о данных Oracle Cloud Infrastructure, Oracle Cloud Infrastructure Kubernetes Engine

Кроме того, для индивидуального развертывания вывода сервер вывода NVIDIA Triton Inference Server глубоко интегрирован со всеми основными поставщиками облачных услуг.

Например, при использовании платформы OCI Data Science развертывание NVIDIA Triton так же просто, как включение переключателя в аргументах командной строки во время развертывания модели, что мгновенно запускает конечную точку вывода NVIDIA Triton.

Google Cloud Platform (рус. «Облачная платформа Google», сокр. GCP) — предоставляемый компанией Google набор облачных служб, которые выполняются на той же самой инфраструктуре, которую Google использует для своих продуктов, предназначенных для конечных потребителей, таких как Google Search и YouTube. Кроме инструментов для управления, также предоставляется ряд модульных облачных служб, таких как облачные вычисления, хранение данных, анализ данных и машинное обучение. Википедия

Google: Google — поисковая система. Google — компания Google Inc. Google Foundation — благотворительный фонд. Google.by — домен и сайт, до 2009 года принадлежавший белорусской компании ActiveMedia. Википедия

Читайте также:HTC объявляет о соглашении XR с GoogleНовые игровые мониторы HP Omen включают 280 Гц IPS Black и опции Google TVMozilla, по-видимому, готовится к антимонопольному иску Google с новым партнером по поискуGoogle анонсирует Android XRСпециалисты Google по искусственному интеллекту Gemini 2.0 проходят обучение, чтобы давать советы и рекомендации по игровому процессу

Платформа вывода ИИ NVIDIA также использует популярные методы коммуникации для предоставления прогнозов ИИ, автоматически подстраиваясь под растущие и меняющиеся потребности пользователей в облачной инфраструктуре.

От ускорения LLM до улучшения творческих рабочих процессов и трансформации управления соглашениями, платформа вывода ИИ от NVIDIA оказывает реальное влияние на все отрасли. Узнайте, как сотрудничество и инновации позволяют организациям ниже достигать новых уровней эффективности и масштабируемости.

Полную версию статьи можно найти здесь.

Узнайте больше о том, как NVIDIA обеспечивает революционные результаты производительности вывода, и будьте в курсе последних обновлений производительности вывода ИИ.

Источник: NVIDIA Blog

0 комментариев