Компания AMD представила AMD OLMo, свой первый LLM с параметрами 1B и убедительной логикой

Advanced Micro Devices, Inc. (AMD, дословный перевод с англ. — «передовые микроустройства») — производитель интегральной микросхемной электроники. Второй по объему производства и продаж производитель процессоров архитектуры x86 c долей рынка 16,9 %▲(2014), а также один из крупнейших производителей графических процессоров (после приобретения ATI Technologies в 2006 году), чипсетов для материнских плат и флеш-памяти. Компания с 2009 года не имеет собственного производства и размещает заказы на мощностях других компаний. Википедия

Читайте также:AMD тихо повышает характеристики Ryzen AI 300 «Strix Point» для поддержки LPDDR5X-8000Впервые AMD обогнала Intel по продажам в сфере центров обработки данныхПортативный OLED-дисплей на базе AMD стремится составить конкуренцию Steam Deck OLEDЭксклюзивная для Китая линейка готовых ПК от AMD получила обновление до Ryzen 7 9800X3DОбновление опроса Steam: самые популярные модели GPU

LLM с открытым исходным кодом от AMD призваны укрепить позиции компании в индустрии искусственного интеллекта и дать возможность ее клиентам (и всем остальным) использовать эти модели с открытым исходным кодом на оборудовании AMD. Используя открытые источники данных, весовые коэффициенты, обучающие рецепты и код, AMD стремится дать разработчикам возможность не только копировать модели, но и использовать их для дальнейших инноваций. Помимо использования в центрах обработки данных, AMD обеспечила локальное развертывание моделей OLMo на компьютерах AMD Ryzen AI, оснащенных нейронными процессорами (NPU), что позволяет разработчикам использовать модели ИИ на персональных устройствах.

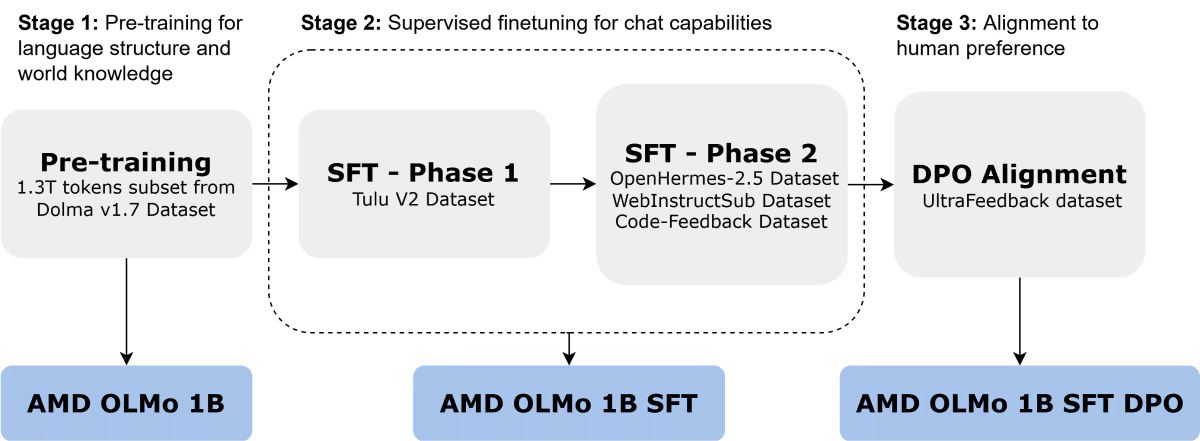

Многоступенчатая предварительная подготовка

Модели AMD OLMo были обучены на обширном наборе данных из 1,3 трлн токенов на 16 узлах, каждый из которых оснащен четырьмя графическими процессорами AMD Instinct MI250 (всего 64 процессора). Обучение линейки моделей AMD OLMo проходило в три этапа.

Изображение: AMD

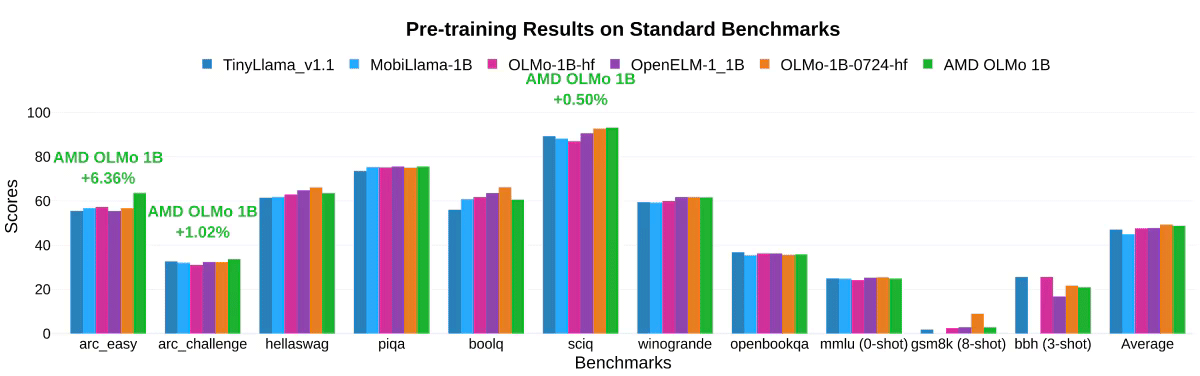

Performance results

Изображение: AMD

В ходе собственного тестирования AMD модели AMD OLMo продемонстрировали впечатляющую производительность по сравнению с аналогичными моделями с открытым исходным кодом, такими как TinyLlama-1.1B, MobiLlama-1B и OpenELM-1_1B, в стандартных тестах на общую логику и понимание многозадачности.

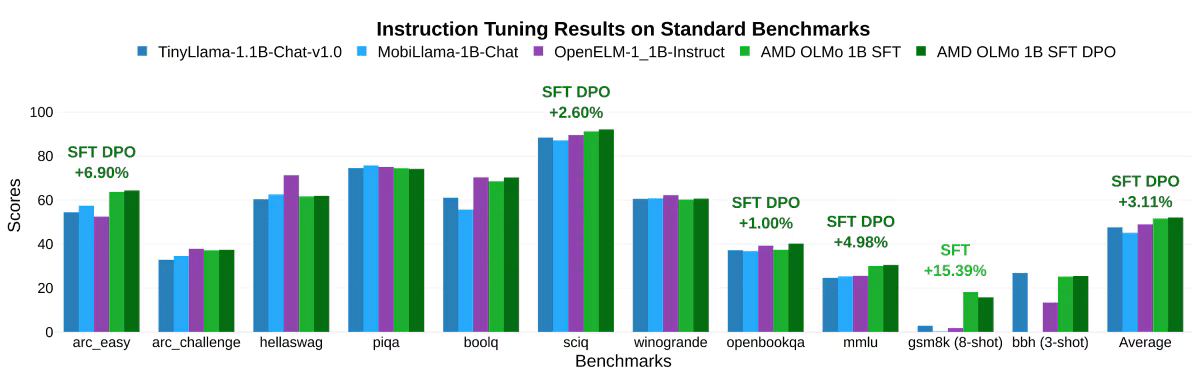

Изображение: AMD

Двухфазная модель SFT значительно улучшила точность: показатели MMLU увеличились на 5,09%, а GSM8k - на 15,32%, что свидетельствует о влиянии подхода AMD к обучению. Финальная модель AMD OLMo 1B SFT DPO превзошла другие модели чата с открытым исходным кодом как минимум на 2,60% в среднем по всем тестам.

Изображение: AMD

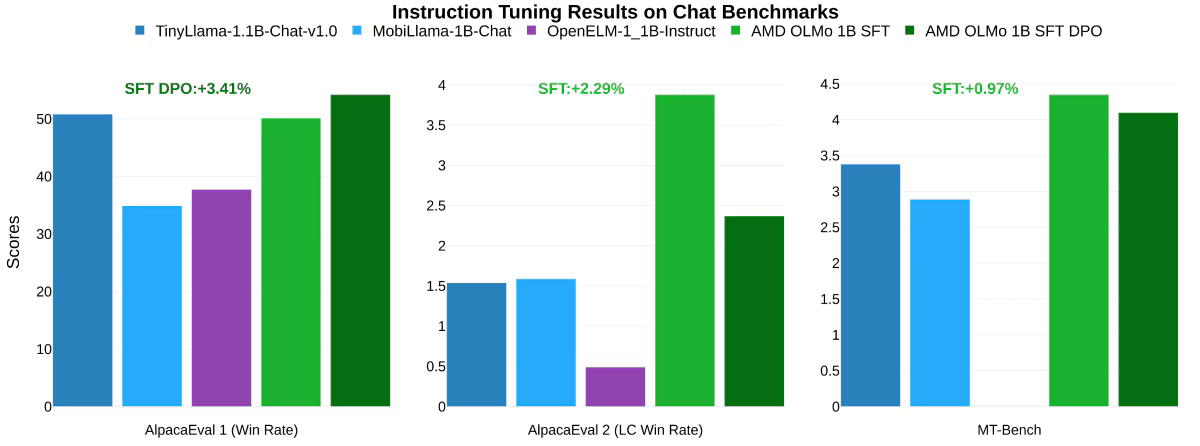

Что касается результатов настройки команд моделей AMD OLMo в тестах чата, то, в частности, при сравнении моделей AMD OLMo 1B SFT и AMD OLMo 1B SFT DPO с другими моделями с настройкой команд, модели AMD превзошли следующего лучшего конкурента по показателям выигрыша AlpacaEval 2 на +3,41% и выигрыша AlpacaEval 2 LC. на +2,29%. Кроме того, в ходе стендового теста MT, в ходе которого оценивались возможности многооборотного общения, модель SFT DPO продемонстрировала прирост производительности на +0,97% по сравнению со своим ближайшим конкурентом.

Изображение: AMD

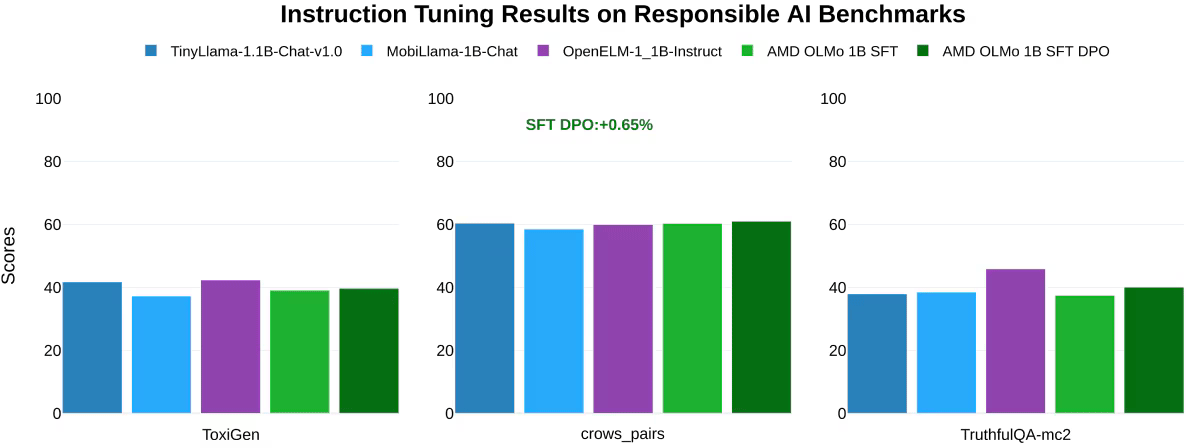

Кроме того, AMD протестировала ответственные тесты искусственного интеллекта, такие как ToxiGen (который измеряет токсичные формулировки, где более низкий балл означает больше), crows_pairs (оценка предвзятости) и TruthfulQA-mc2 (оценка правдивости ответов). Было обнаружено, что модели AMD OLMo не уступают аналогичным моделям в решении этичных и ответственных задач искусственного интеллекта.

Источник: Tomshardware.com

0 комментариев