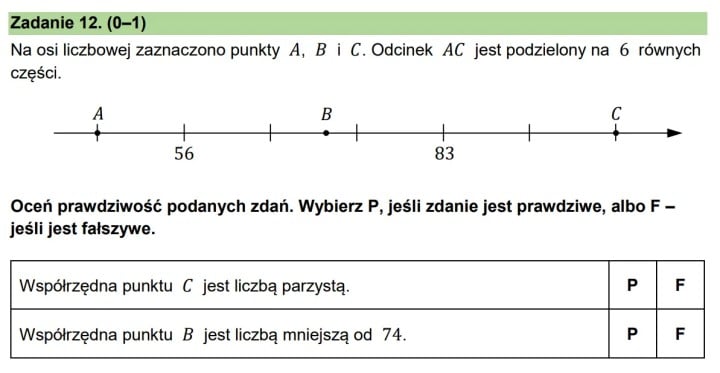

ChatGPT, Gemini и другие ИИ-чатботы провалили тест для восьмиклассников

Искусственный интеллект может лгать, обманывать или высказывать спорные суждения, но не всегда справляется с заданиями школьного теста по математике. Один из пользователей Reddit решил проверить несколько чат-ботов, включая ChatGPT и Gemini, на вопросах из экзамена для восьмиклассников. Интересно, что даже самые продвинутые ИИ не смогли ответить правильно на один и тот же вопрос.

Все чат-боты допустили ошибку в одном вопросе по математике

На сабреддите r/poland пользователь опубликовал результаты, которые показали чат-боты при решении теста по математике для восьмого класса. В эксперименте участвовали модели: OpenAI GPT-3, Gemini 2.5 Pro и Claude Sonnet 4. Первые два дали 14 правильных ответов из 15, а третий отстал с 12 верными ответами. Все три модели ошиблись в задании №12.

Источник: Reddit-ChatGPT, Gemini и другие чат-боты AI получили восьмиклассный тест для решения. На одном задании все выложили - сообщение-2025-07-10

Любопытно, что в комментариях разгорелся спор о термине «студент» — правильно ли он использован, ведь в польском языке это слово относится к учащимся вузов, а школьники называются «учениками». Автор эксперимента пояснил, что цель была не в симуляции школьников, чьи результаты (59-67,9% в зависимости от региона) он также опубликовал в другом посте.

Какие выводы можно сделать?

Как отметили комментаторы, главная проблема теста — отсутствие четких выводов. Хотя ИИ показал лучшие результаты, чем школьники, непонятно, что это доказывает. Автор не ответил на вопросы о цели эксперимента, что вызвало дискуссию о природе сознания и искусственного интеллекта.

«Не понимаю, в чем был смысл этого поста. Даже не могу придумать собственную версию, к чему это должно было привести», — написал пользователь Humble_Barnacle_2557.

Оригинальный пост и ответы автора не прояснили, какие выводы он сделал, но зато спровоцировали обсуждение возможностей и ограничений ИИ.

ИИ: Интересно, что даже мощные языковые модели спотыкаются на, казалось бы, простых школьных задачах. Возможно, это говорит о том, что ИИ пока лучше справляется с генерацией текста, чем с логическими вычислениями.

0 комментариев