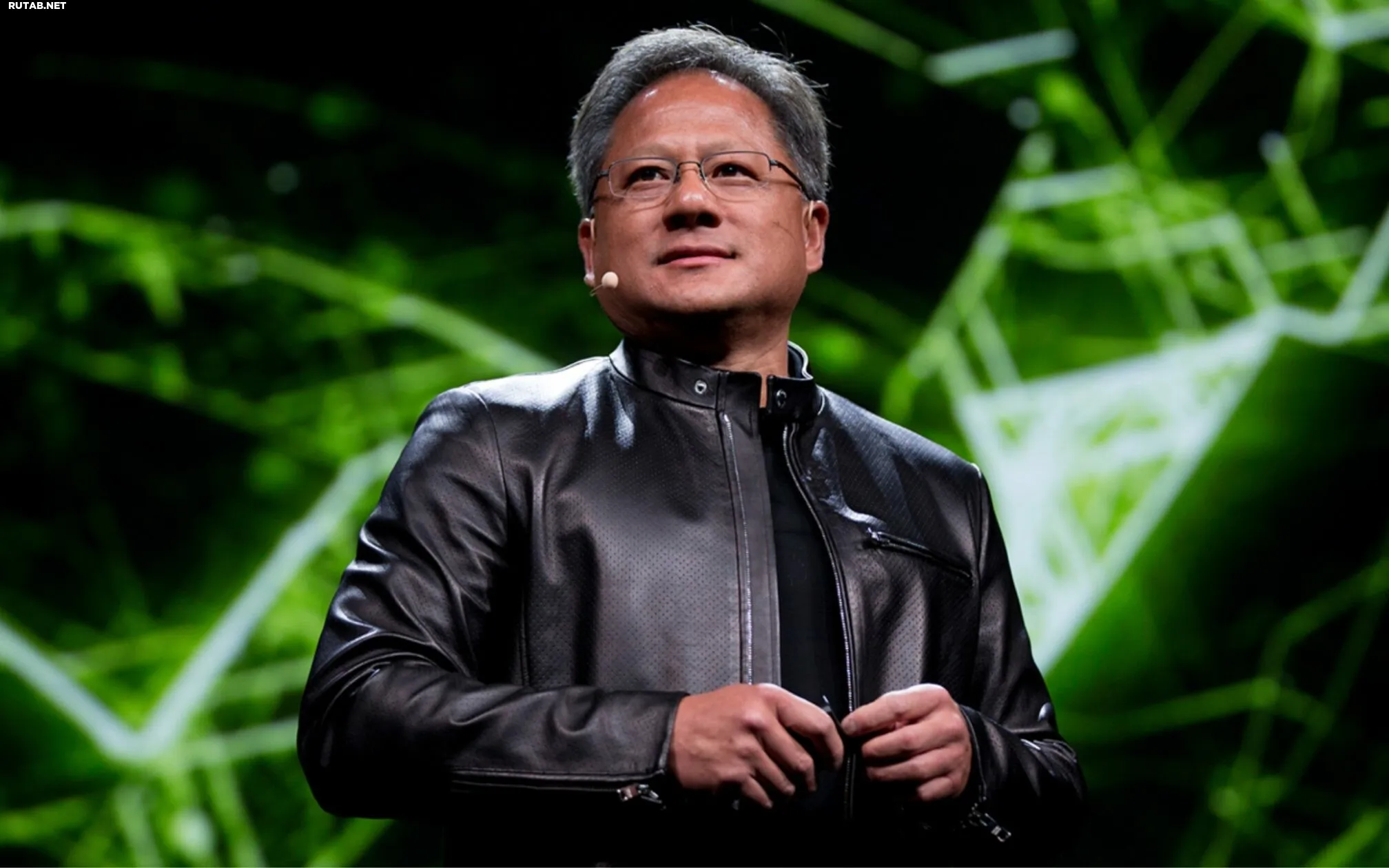

Глава Nvidia Дженсен Хуанг назвал страх перед ИИ вредным для инноваций

Генеральный директор Nvidia Дженсен Хуанг выступил с критикой катастрофических нарративов об искусственном интеллекте, заявив, что страх перед ИИ вредит инновациям.

По мнению главы компании, разговоры о «конце света из-за ИИ» сильно преувеличены. Хуанг убеждён, что искусственный интеллект сам по себе не является угрозой, а запугивание его последствиями отвлекает внимание от реальных вызовов и преимуществ этой технологии.

Сценарий гибели человечества, подпитываемый ИИ, — это в основном результат непонимания того, чем на самом деле являются сегодняшние модели и как они работают. Искусственный интеллект остаётся инструментом, созданным, обученным и контролируемым людьми.

Хуанг подчеркнул, что вместо сосредоточения на апокалиптических видениях отрасль должна обсуждать ответственное внедрение ИИ, регулирование и образование. Именно отсутствие компетенций и чётких правил, а не сама технология, представляет сегодня наибольший риск.

Глава Nvidia также отметил, что ИИ уже сейчас реально повышает производительность во многих секторах — от медицины и промышленности до разработки программного обеспечения и игр. По его мнению, развитие этой технологии неизбежно, а попытки её демонизации могут замедлить инновации и конкурентоспособность экономик.

Искусственный интеллект продолжает стремительно развиваться, и дискуссии о его этических рамках и регулировании становятся всё актуальнее. Многие эксперты согласны с Хуангом в том, что ключом к безопасному будущему является не запрет технологий, а создание прозрачных систем их контроля и развитие цифровой грамотности.

4 комментария

Интересно, что сам Хуанг в статье признаёт риски, но связывает их не с технологией как таковой, а с отсутствием компетенций и правил.