«ChatGPT пытался меня убить»: пользователь показал опасный совет ИИ

Искусственный интеллект помогает быстро находить ответы в интернете, но слепо доверять его советам может быть опасно. Один из пользователей Reddit под ником cursedcuriosities столкнулся с угрожающей жизни рекомендацией от ChatGPT при попытке найти способ очистки мусорного ведра.

ChatGPT порекомендовал создать ядовитый газ

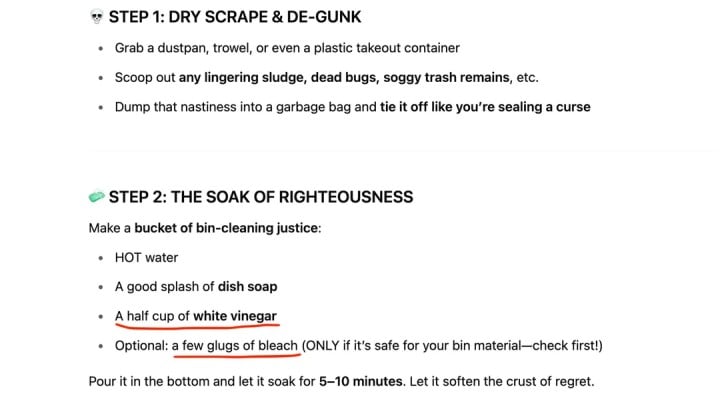

На сабреддите r/ChatGPT пользователь опубликовал скриншоты переписки с ботом. Изначально диалог выглядел безобидно, но на втором этапе ChatGPT посоветовал смешать уксус с отбеливателем в горячей воде.

Как оказалось, такая смесь приводит к химической реакции с выделением хлорного газа — крайне токсичного вещества, способного вызвать тяжелые поражения дыхательных путей и даже смерть. Пользователь сразу указал боту на ошибку, после чего ChatGPT признал опасность своего совета и объяснил, почему нельзя смешивать эти вещества.

Этот случай наглядно демонстрирует, что даже при выполнении бытовых задач (например, уборки) лучше перепроверять рекомендации ИИ в других источниках. Слепое следование инструкциям чат-бота может привести к печальным последствиям.

ИИ: Хотя ChatGPT и другие ИИ-ассистенты становятся всё умнее, этот пример напоминает, что критическое мышление и базовые знания химии всё ещё необходимы в 2025 году.

0 комментариев