FramePack может генерировать ИИ-видео локально, используя всего 6 ГБ видеопамяти

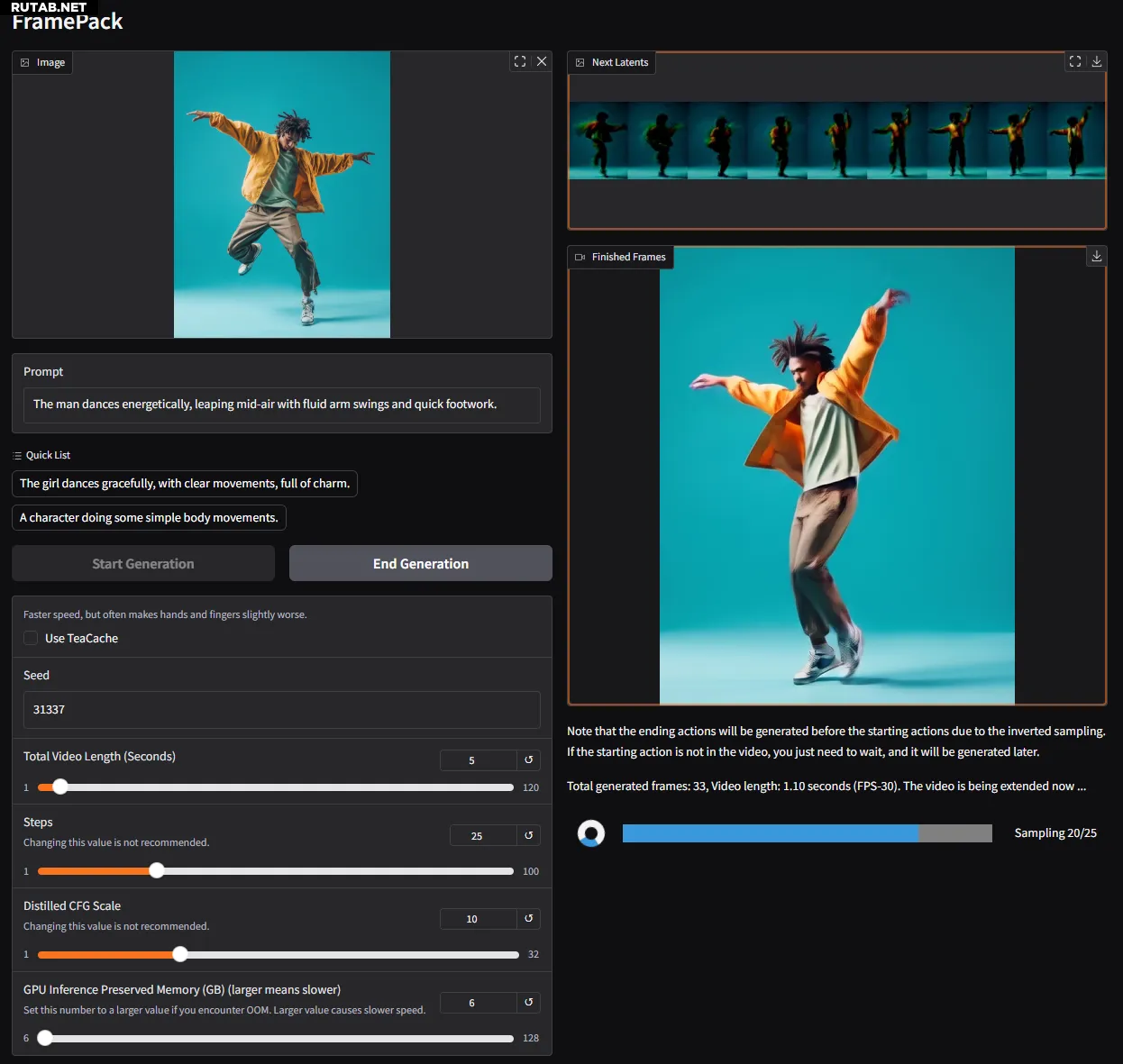

Lvmin Zhang из GitHub в сотрудничестве с Maneesh Agrawala из Стэнфордского университета представили FramePack на этой неделе. FramePack предлагает практическую реализацию диффузии видео с использованием временного контекста фиксированной длины для более эффективной обработки, что позволяет создавать более длинные и качественные видео. Модель с 13 миллиардами параметров, созданная с использованием архитектуры FramePack, может генерировать 60-секундный клип всего с 6 ГБ видеопамяти.

FramePack — это архитектура нейронной сети, которая использует многоступенчатые методы оптимизации для обеспечения локальной генерации видео AI. На момент написания статьи сообщалось, что графический интерфейс FramePack использует под капотом пользовательскую модель на основе Hunyuan, хотя в исследовательской статье упоминается, что существующие предварительно обученные модели можно настраивать с помощью FramePack.

Типичные модели диффузии обрабатывают данные из ранее сгенерированных шумных кадров для прогнозирования следующего, немного менее шумного кадра. Количество входных кадров, рассматриваемых для каждого прогноза, называется длиной временного контекста, которая растет с размером видео. Стандартные модели диффузии видео требуют большого пула VRAM, причем 12 ГБ являются обычной отправной точкой. Конечно, вы можете обойтись меньшим объемом памяти, но это приводит к более коротким клипам, более низкому качеству и более длительному времени обработки.

Введите FramePack: новая архитектура, которая сжимает входные кадры, в зависимости от их важности, в фиксированную длину контекста, радикально сокращая накладные расходы памяти GPU. Все кадры должны быть сжаты, чтобы сходиться к желаемой верхней границе для длины контекста. Авторы описывают вычислительные затраты как аналогичные диффузии изображений.

Изображение: GitHub

В сочетании с методами смягчения «дрейфа», когда качество ухудшается с длиной видео, FramePack предлагает более длинную генерацию видео без существенного ущерба для точности. В настоящее время FramePack требует GPU серии RTX 30/40/50 с поддержкой форматов данных FP16 и BF16. Поддержка Turing и более старых архитектур не была проверена, без упоминания оборудования AMD/Intel. Linux также входит в число поддерживаемых операционных систем.

За исключением RTX 3050 4 ГБ, большинство современных (RTX) графических процессоров соответствуют или превосходят критерии 6 ГБ. С точки зрения скорости RTX 4090 может выдавать до 0,6 кадров в секунду (оптимизировано с помощью teacache), поэтому ваш пробег будет зависеть от вашей видеокарты. В любом случае, каждый кадр будет отображаться после его генерации, обеспечивая немедленную визуальную обратную связь.

Используемая модель, вероятно, имеет ограничение в 30 FPS, что может быть ограничением для многих пользователей. Тем не менее, вместо того, чтобы полагаться на дорогостоящие сторонние сервисы, FramePack прокладывает путь к тому, чтобы сделать генерацию видео с помощью ИИ более доступной для среднего потребителя. Даже если вы не создатель контента, это развлекательный инструмент для создания GIF-файлов, мемов и всего такого. Я знаю, что попробую это в свободное время.

Источник: Tomshardware.com

0 комментариев