Моддер впихивает LLM в USB-накопитель Pi Zero

Локальное использование LLM растет, и поскольку многие настраивают ПК или системы для их запуска, идея запуска LLM на сервере где-то в облаке быстро устаревает.

Бинь Фам экспериментировал с Raspberry Pi Zero, фактически превратив устройство в небольшой USB-накопитель, который может запускать LLM локально без необходимости в дополнительных компонентах. Проект был в значительной степени облегчен благодаря llama.cpp и llamafile, комбинации набора инструкций и серии пакетов, разработанных для предоставления легкого опыта чат-бота в автономном режиме.

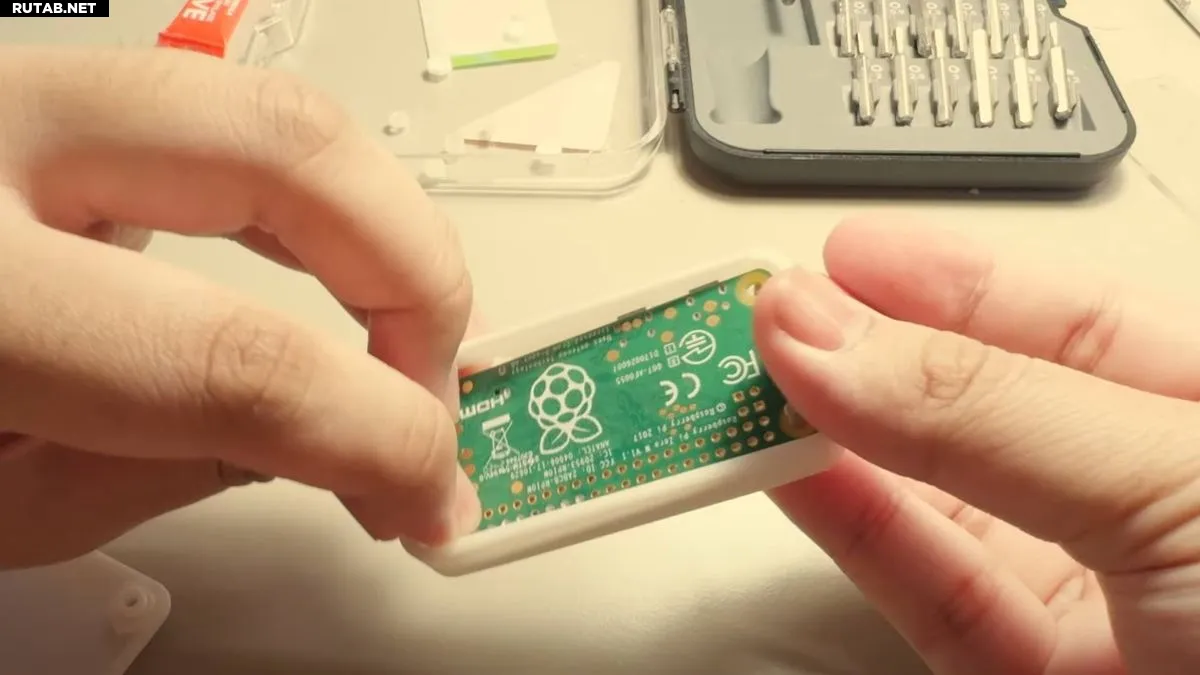

Но поскольку Pi Zero было восемь лет, это было не так просто, как запаковать llama.cpp в Pi Zero и запустить его. Во-первых, Фам установил устройство на USB-интерфейс и напечатал на 3D-принтере оболочку для самого устройства.

После всего этого проект стал еще более сложным из-за ограничения памяти ОЗУ Pi Zero W в 512 МБ. После сборки llama.cpp на устройство он не смог скомпилироваться, и никто больше не осмелился собрать llama.cpp на Pi Zero или Pi One.

Корень проблем кроется в процессоре Pi Zero, работающем на ARMv6. Чтобы обойти это, ему пришлось взяться за дело и преобразовать набор инструкций ARMv8 llama.cpp и удалить любые обозначения или оптимизации, основанные на современном оборудовании.

После редактирования исходного кода llama.cpp для запуска на Pi Zero ему нужно было заставить работать программную часть флешки. Затем его внимание переключилось на то, чтобы сделать программный опыт максимально гладким.

Сам LLM построен вокруг отправки текстовых файлов в LLM, который служит в качестве основного приглашения. Поэтому Фам построил свою реализацию, которая генерирует историю на основе текстового приглашения и выдает ее обратно в виде полностью заполненного файла со сгенерированными выходными данными.

Установив лимит токенов на 64, он провел несколько тестов с несколькими моделями в диапазоне от 15 до 136 млн. Модель Tiny15M достигла скорости 223 мс на токен, в то время как две более крупные модели Lamini-T5-Flan-77M достигли более высокой скорости 2,5 с на токен, а модель SmolLM2-136M достигла 2,2 с на токен.

Скорости токена на самом деле означают, что он будет слишком медленным для использования во многих практических приложениях. Хотя это интересный проект, использование старого, легкого оборудования для запуска локального LLM может не дать большого практического применения. Вместо этого вы можете захотеть использовать гораздо более сложную модель, например, запустить Deepseek на Raspberry Pi 5.

Источник: Tomshardware.com

0 комментариев