Илон Маск удваивает крупнейший в мире кластер AI GPU

NVIDIA Corporation (NASDAQ: NVDA) — американская компания, один из крупнейших разработчиков графических ускорителей и процессоров, а также наборов системной логики. На рынке продукция компании известна под такими торговыми марками как GeForce, nForce, Quadro, Tesla, ION и Tegra. Компания была основана в 1993 году. По состоянию на август 2006 года в корпорации насчитывалось более 8 тысяч сотрудников, работающих в 40 офисах по всему миру. Википедия

Читайте также:Сетевое оборудование NVIDIA ускоряет работу суперкомпьютера xAIДрайвер GPU Nvidia устраняет 8 основных уязвимостейИдентификаторы мобильных устройств Nvidia RTX 50 были слиты в сетьReliance строит центр обработки данных с графическими процессорами Nvidia Blackwell AIГенеральный директор Nvidia Йенсен Хуан и король Дании подключают первый в стране суперкомпьютер с искусственным интеллектом

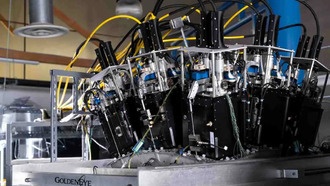

Итак, суперкомпьютер xAI Colossus AI находится на пути «скоро к тому, чтобы стать 200-тысячным учебным кластером H100/H200 в одном здании». Его воплощение в 100 000 GPU, которое только что начало обучение ИИ около двух недель назад, уже было заметным. Хотя мы думаем, что «скоро» в данном случае действительно может быть скоро. Однако предыдущие задержки Маска в технических сроках (например, полное беспилотное вождение Tesla, задержки Hyperloop, трудности SolarCity) означают, что нам следует быть в целом осторожными с его дальновидными хвастовствами.

xAI Colossus уже окрестили инженерным чудом. Важно отметить, что похвала мастерству суперкомпьютера не ограничивается обычными прихлебателями Маска. Генеральный директор Nvidia Дженсен Хуанг также описал этот проект суперкомпьютера как «сверхчеловеческий» подвиг, который «никто раньше не делал». Инженеры xAI, должно быть, очень усердно и много работали, чтобы настроить суперкомпьютер xAI Colossus AI за 19 дней. Обычно проекты такого масштаба и сложности могут занять до четырех лет, указал Хуанг.

Для чего будут использоваться 200 000 графических процессоров H100/H200? Этот весьма значительный вычислительный ресурс, вероятно, не будет направлен на совершение научных прорывов на благо человечества. Вместо этого 200 000 энергоемких графических процессоров, скорее всего, предназначены для обучения моделей ИИ и чат-ботов, таких как Grok 3, наращивая мощь его очищенных машинным обучением «антипробуждающих» реплик.

Это не аппаратный финал для аппаратного расширения xAI Collosus, далеко не так. Ранее Маск рекламировал Colossus, вмещающий 300 000 графических процессоров Nvidia H200, пульсирующих внутри.

При нынешних темпах модернизации мы могли бы даже увидеть твит Маска о достижении этой цели в 300 000 до конца 2024 года. Возможно, если что-то и задержит «Grok 300 000», то это могут быть факторы, не зависящие от Маска, например, поставки графических процессоров. Ранее мы также сообщали, что локальную генерацию электроэнергии пришлось усилить, чтобы справиться даже с первой стадией Colossus от xAI, так что это еще одно препятствие — наряду со сложным жидкостным охлаждением и сетевым оборудованием.

Источник: Tomshardware.com

0 комментариев