Nvidia Hopper H200 побил рекорд теста MLPerf с TensorRT

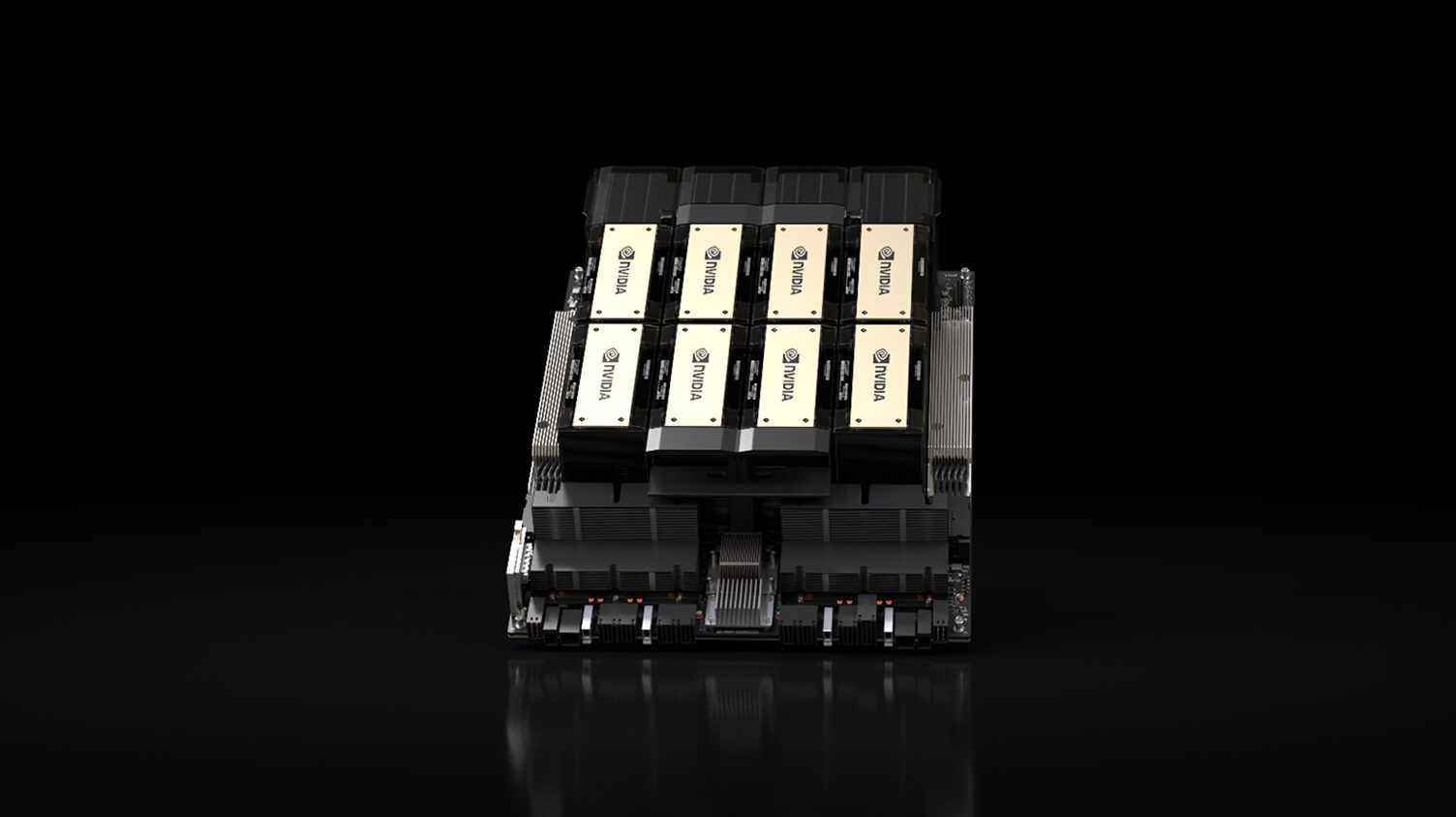

Nvidia сообщает, что ее новый графический процессор Hopper H200 AI в сочетании с повышающей производительность TensorRT LLM побил рекорд в последних тестах производительности MLPerf. Объединение вместе повысило производительность H200 до колоссальных 31 712 токенов в секунду в тесте Llama 2 70B от MLPerf, что на 45% лучше, чем у графического процессора Nvidia H100 Hopper предыдущего поколения.

Hopper H200 по сути представляет собой тот же чип, что и H100, но память была обновлена до стеков HBM3e 12-Hi емкостью 24 ГБ. В результате получается 141 ГБ памяти на каждый графический процессор с пропускной способностью 4,8 ТБ/с, тогда как у H100 обычно было только 80 ГБ на графический процессор (94 ГБ на некоторых моделях) с пропускной способностью до 3 ТБ/с.

Этот рекорд, несомненно, будет побит позднее в этом или начале следующего года, когда на рынок выйдут новые графические процессоры Blackwell B200. У Nvidia, скорее всего, есть Blackwell, и она проходит тестирование, но она пока не является общедоступной. Однако производительность при учебных нагрузках была в 4 раза выше, чем у H100.

Nvidia — единственный производитель оборудования для искусственного интеллекта на рынке, опубликовавший полные результаты с тех пор, как в конце 2020 года стали доступны тесты вывода MLPerf для центров обработки данных. Последняя версия нового теста MLPerf использует Llama 2 70B — современную языковую модель. используя 70 миллиардов параметров. Llama 2 более чем в 10 раз больше, чем GPT-J LLM, который ранее использовался в тестах MLPerf.

Тесты MLPerf — это набор тестов, разработанный ML Commons, предназначенный для обеспечения объективной оценки производительности обучения и вывода программного обеспечения, оборудования и услуг. Весь набор тестов состоит из множества проектов нейронных сетей искусственного интеллекта, включая GPT-3, Stable Diffusion V2 и DLRM-DCNv2, и это лишь некоторые из них.

Nvidia также подчеркнула, насколько ей удалось повысить производительность графического процессора H100 с помощью программного обеспечения TensorRT — набора инструментов с открытым исходным кодом, помогающего повысить эффективность обработки графических процессоров. TensorRT состоит из нескольких элементов, включая тензорный параллелизм и пакетную обработку в реальном времени. Тензорный параллелизм использует отдельные весовые матрицы для эффективного запуска модели искусственного интеллекта на нескольких графических процессорах и серверах. Пакетная обработка в реальном времени удаляет завершенные последовательности пакетных запросов и начинает выполнять новые запросы, пока другие еще находятся в работе.

Улучшения TensorRT применительно к тесту MLPerf GPT-J привели к трехкратному улучшению производительности за последние шесть месяцев — для того же оборудования.

Nvidia также подчеркнула свою производительность в MLPerf Llama 2 70B по сравнению с решением Intel Gaudi2 NPU. Согласно диаграммам Nvidia, H200 достиг мирового рекорда в 31 712 баллов в режиме сервера с улучшениями TensorRT-LLM. В автономном режиме чип набрал 29 526 баллов. Новые результаты H200 примерно на 45% выше, чем у H100, во многом благодаря большей пропускной способности и емкости памяти. В том же тесте с использованием TensorRT H100 набрал 21 806 и 20 556 баллов в серверном и автономном режимах соответственно. Для сравнения, результаты Intel Gaudi2 составили всего 6287 и 8035 в серверном и автономном режимах.

Помимо TensorRT, Nvidia интегрировала в свои графические процессоры несколько других оптимизаций. Сообщается, что структурированная разреженность увеличивает скорость вывода на 33% с помощью Llama 2 за счет сокращения вычислений на графическом процессоре. Сокращение — это еще одна оптимизация, которая упрощает модель искусственного интеллекта или LLM для увеличения пропускной способности вывода. DeepCache сокращает математические вычисления, необходимые для вывода с помощью моделей Stable Diffusion XL, повышая производительность на 74%.

0 комментариев